信息论与互信息

在信息论中,熵是接收的每条消息中包含的信息的平均量,又被称为信息熵、信源熵、平均自信息量。

在信息世界中,熵越高,则能传输越多的信息,熵越低,则意味着传输的信息越少。

自信息:

1、自信息表示事件发生前,事情发生的不确定性

2、自信息表示事件发生后,事件所包含的信息量,是提供给新宿的信息量,也是解除这种不确定性所需要的信息量。

互信息:

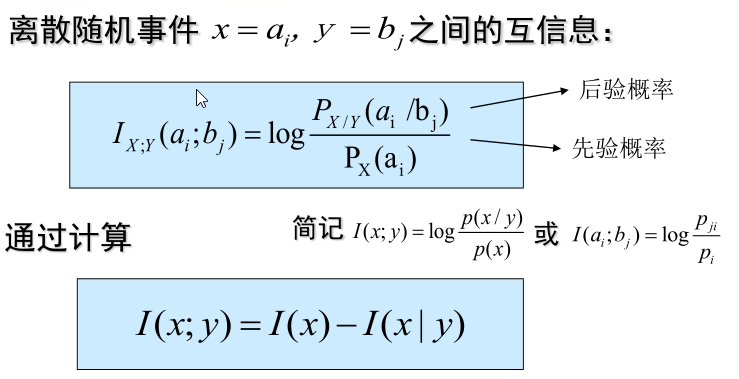

离散随机事件之间的互信息:

事件x,y之间的互信息等于“x的自信息”减去“y条件下x的自信息”,I(x)表示x的不确定性,I(x|y)表示在y发生条件下,x的不确定性

I(x;y)表示当y发生后x不确定性的变化,两个不确定度之差,是不确定度消除的部分,代表已经确定的东西,实际就是由y发生所得到的关于x的信息量。

互信息可正可负,而自信息一定是正的,所以任何两事件之间的互信息不可能大于其中任一事件的自信息。

信息熵:

含义:1、在信源输出后,表示每个信源符号所提供的平均信息量。2、在信源输出前,表示信源的平均不确定性。3、表示信源随机性大小,H(x)大的,随机性大。4、当信源输出后,不确定性解除,熵可视为解除信源不确定性所需的信息量。

作者:Zahen

相关文章

Sachi

2020-04-10