论文笔记:《Network Dissection: Quantifying Interpretability of Deep Visual Representations》

CVPR 2017 的 MIT 论文《Network Dissection: Quantifying Interpretability of Deep Visual Representations》

其项目网页:Network Dissection

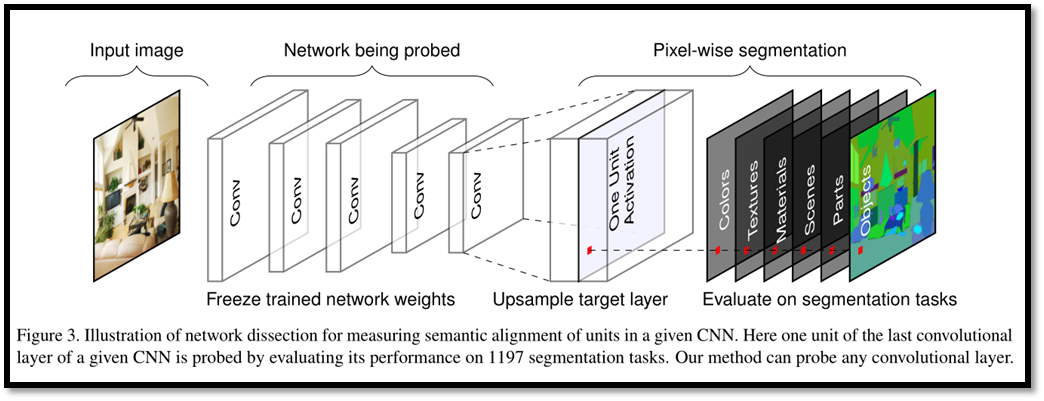

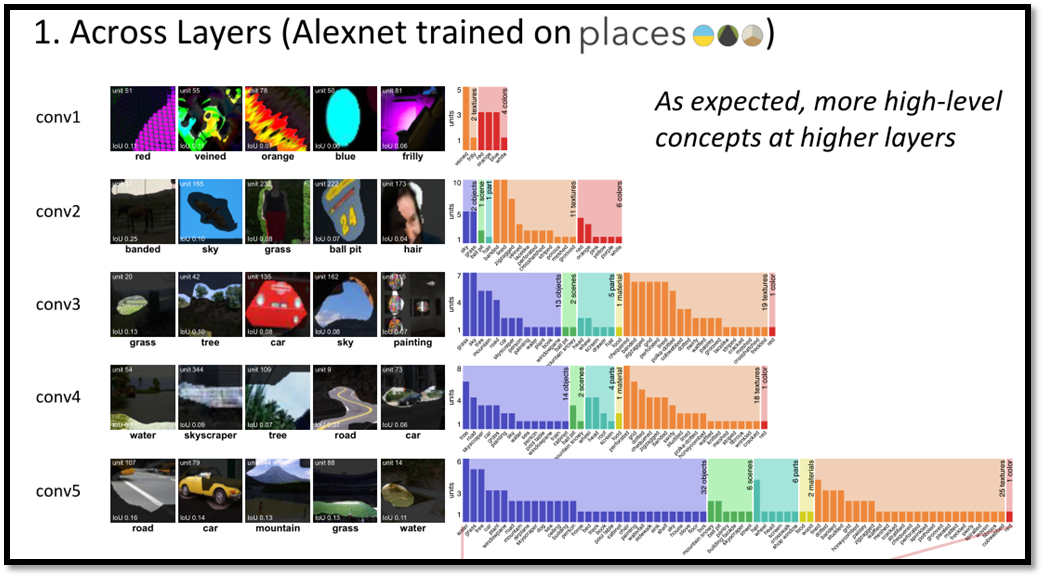

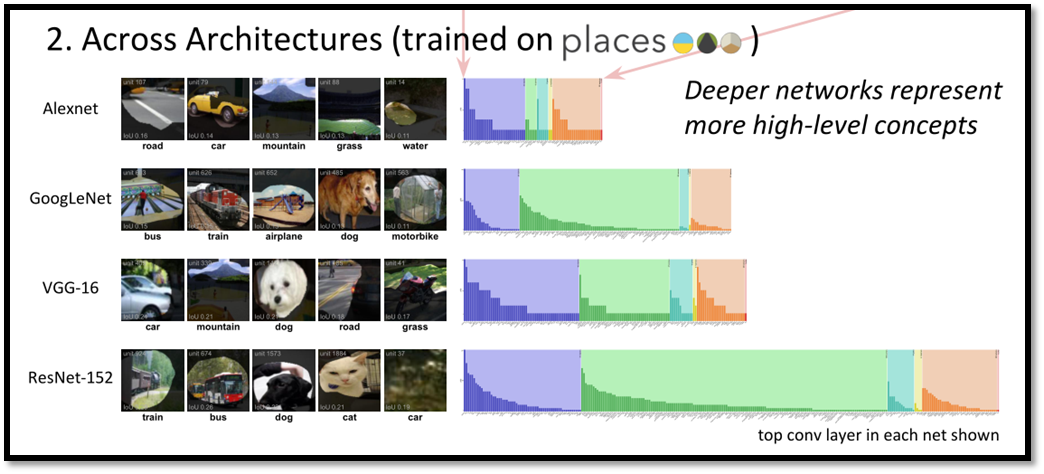

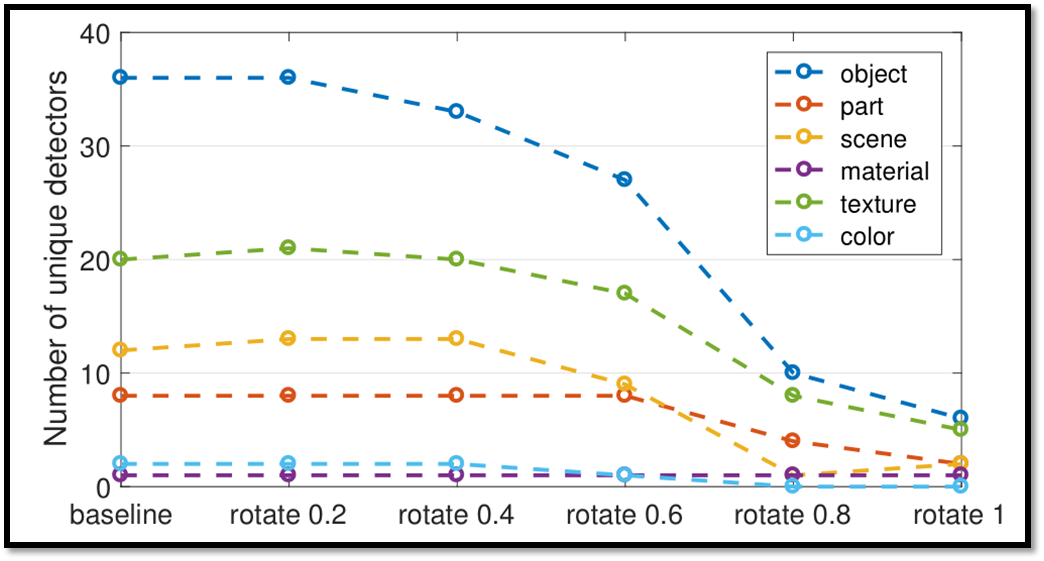

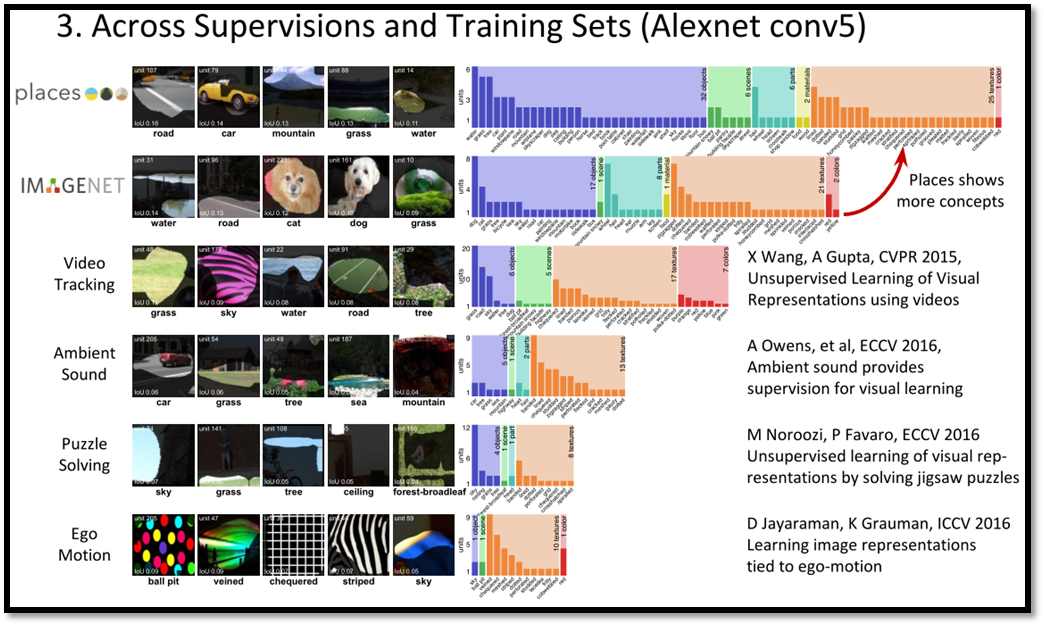

直接剖析其他任务中训练好的 CNN 模型,解释其神经元对应的语义概念

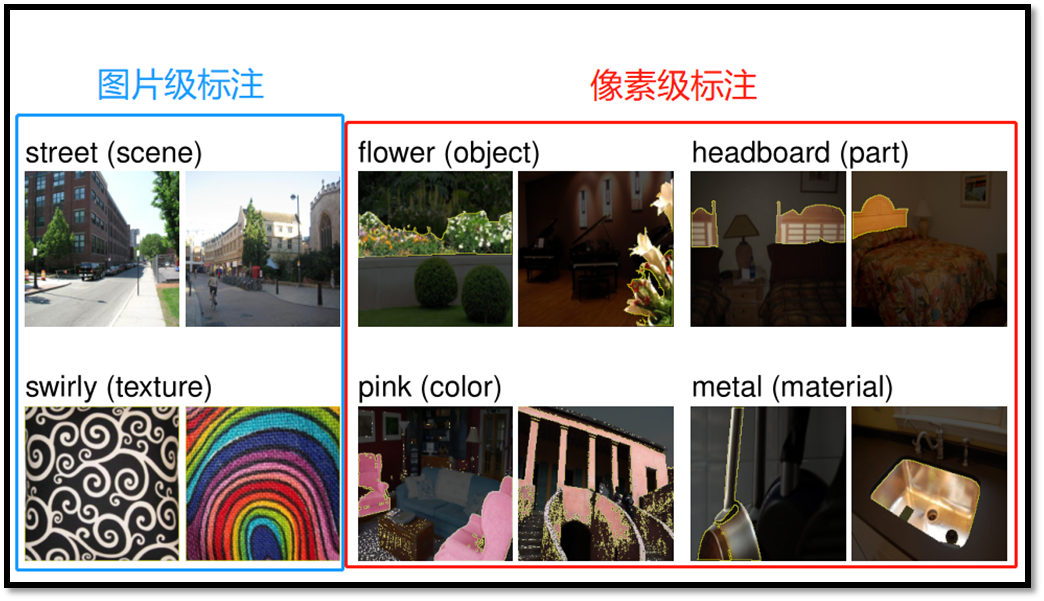

【方法概要】 (1)构建一个包括多层次图片(从简单颜色纹理到复杂场景物体)并在像素级别人工标注了语义的 Broden 数据集;

仅能较好解释 CNN 模型中对 Broden 数据集中有定义的语义概念的响应。

【提出并分析了三个问题】 (1)什么是神经网络的可解释表示,其要素如何检测、量化?

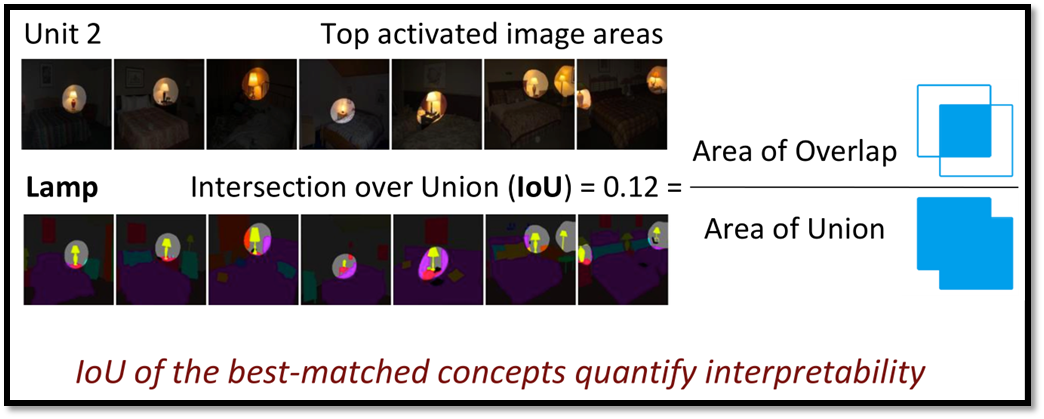

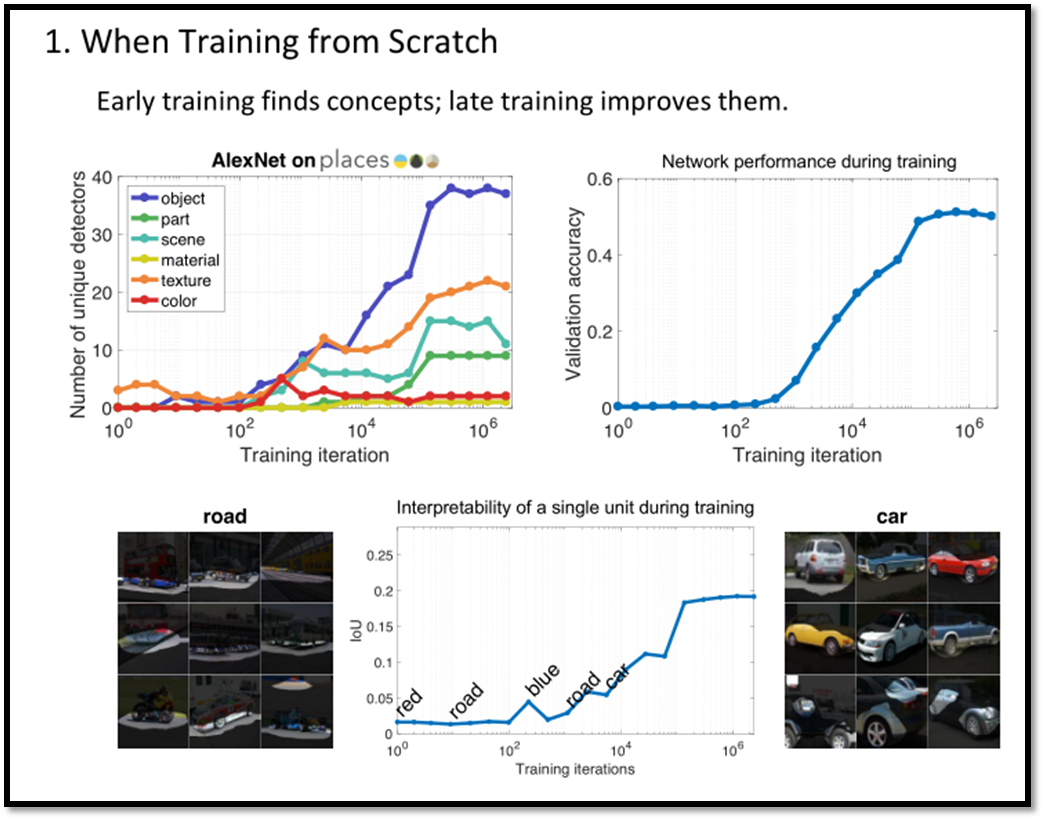

测量、量化方法见上;提出了一个量化的单位 IoU(intersection over union),计算公式为((像素级语义划分范围)∩(神经元激活区域))/(二者的并集)

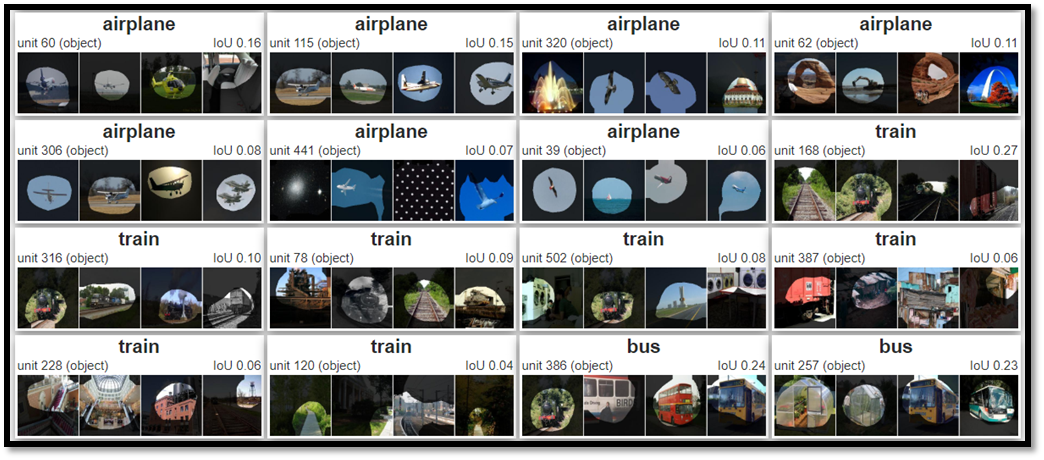

一个语义概念可能被多个神经元检测到,一个神经元也可能检测多个语义。

其中只看一个神经元中 IoU 最高的语义。

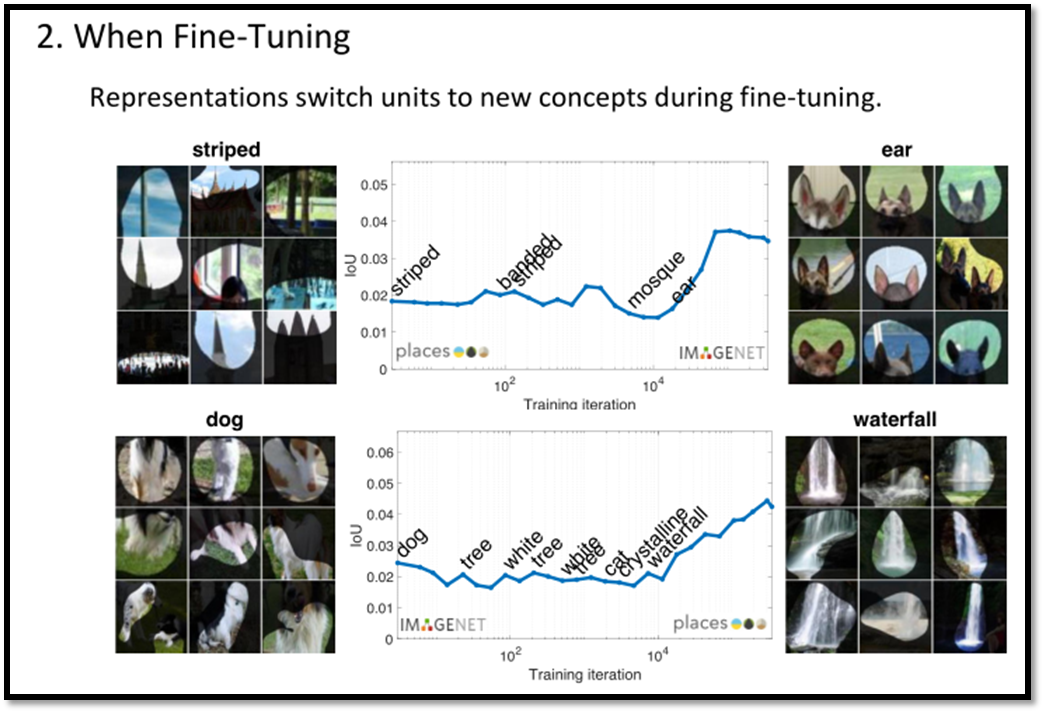

Fine Tuning 可以提高神经元可解释性

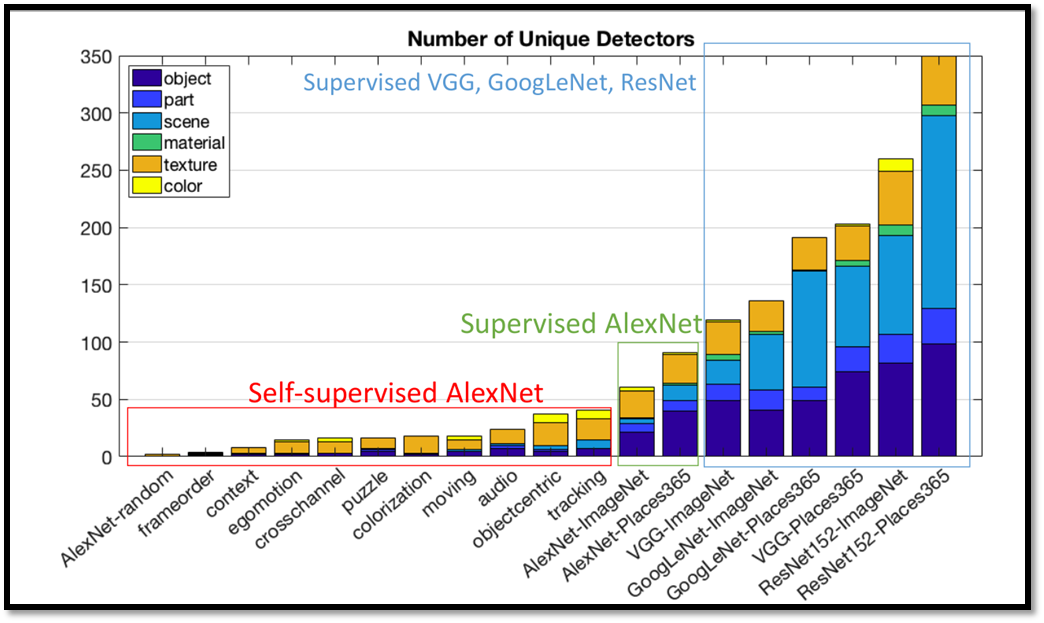

有监督 > 自监督

欢迎讨论

我才是一卓

我才是一卓

原创文章 6获赞 2访问量 1774

关注

私信

展开阅读全文

原创文章 6获赞 2访问量 1774

关注

私信

展开阅读全文

作者:我才是一卓