Deep learning Pytorch 2002-2

过拟合、欠拟合及其解决方案

L2范数惩罚项通过惩罚绝对值较大的参数的方法来应对过拟合的

L2正则化是在目标函数中直接加上一个正则项,直接修改了我们的优化目标。权值衰减是在训练的每一步结束的时候,对网络中的参数值直接裁剪一定的比例,优化目标的式子是不变的。在使用朴素的梯度下降法时二者是同一个东西,因为此时L2正则化的正则项对梯度的影响就是每次使得权值衰减一定的比例。但是在使用一些其他优化方法的时候,就不一样了。比如说使用Adam方法时,每个参数的学习率会随着时间变化。这时如果使用L2正则化,正则项的效果也会随之变化;而如果使用权值衰减,那就与当前的学习率无关了,每次衰减的比例是固定的。L2正则化是权重衰减的一种方式

惩罚绝对值较大的参数意思为,L2范数正则化处理过拟合的手段是使参数变小,接近于零,越小的参数模型也就越简单,所以惩罚绝对值较大的参数。L2范数惩罚 卷积神经网络基础

作者:烊烊烊哼圆烊

L2正则化是在目标函数中直接加上一个正则项,直接修改了我们的优化目标。权值衰减是在训练的每一步结束的时候,对网络中的参数值直接裁剪一定的比例,优化目标的式子是不变的。在使用朴素的梯度下降法时二者是同一个东西,因为此时L2正则化的正则项对梯度的影响就是每次使得权值衰减一定的比例。但是在使用一些其他优化方法的时候,就不一样了。比如说使用Adam方法时,每个参数的学习率会随着时间变化。这时如果使用L2正则化,正则项的效果也会随之变化;而如果使用权值衰减,那就与当前的学习率无关了,每次衰减的比例是固定的。L2正则化是权重衰减的一种方式

惩罚绝对值较大的参数意思为,L2范数正则化处理过拟合的手段是使参数变小,接近于零,越小的参数模型也就越简单,所以惩罚绝对值较大的参数。L2范数惩罚 卷积神经网络基础

卷积神经网络基础链接

二维互相关运算:

二维互相关(cross-correlation)运算的输入是一个二维输入数组和一个二维核(kernel)数组,输出也是一个二维数组,其中核数组通常称为卷积核或过滤器(filter)

二维卷积层:

二维卷积层将输入和卷积核做互相关运算,并加上一个标量偏置来得到输出。卷积层的模型参数包括卷积核和标量偏置。

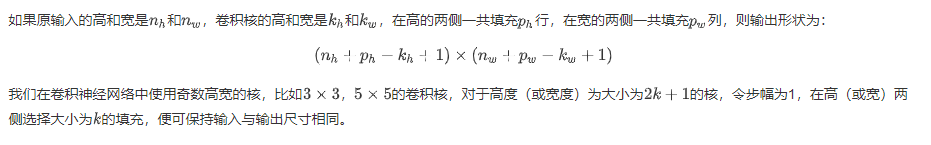

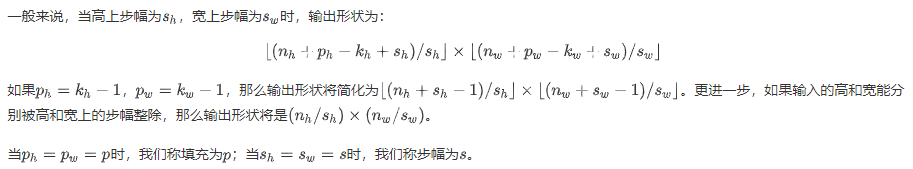

填充和步幅

nn.Conv2d:nn.Conv2d简单说明

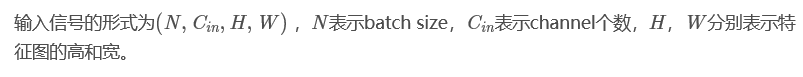

nn.Conv2d的功能是:对由多个输入平面组成的输入信号进行二维卷积,以最简单的例子进行说明:

参数说明:

参数说明:

stride(步长):控制cross-correlation的步长,可以设为1个int型数或者一个(int, int)型的tuple。

padding(补0):控制zero-padding的数目。

dilation(扩张):控制kernel点(卷积核点)的间距; 也被称为 "à trous"算法. 可以在此github地址查看:Dilated convolution animations

groups(卷积核个数):这个比较好理解,通常来说,卷积个数唯一,但是对某些情况,可以设置范围在1 —— in_channels中数目的卷积核:

————————————————

版权声明:本文为CSDN博主「sooner高」的原创文章,遵循CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/g11d111/article/details/82665265

作者:烊烊烊哼圆烊