StirngBoot+ELK+Kafka记录日志,超详细搭建过程!

可以非常快速的查询StirngBoot日志,达到出现异常及时告警,异常分类统计功能。

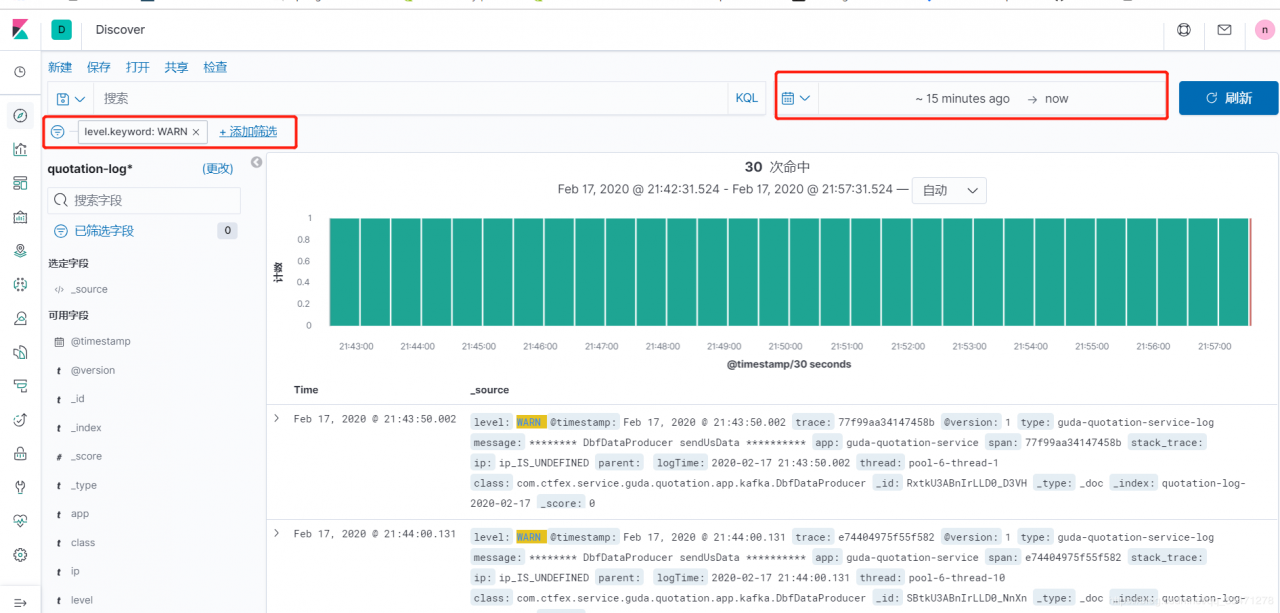

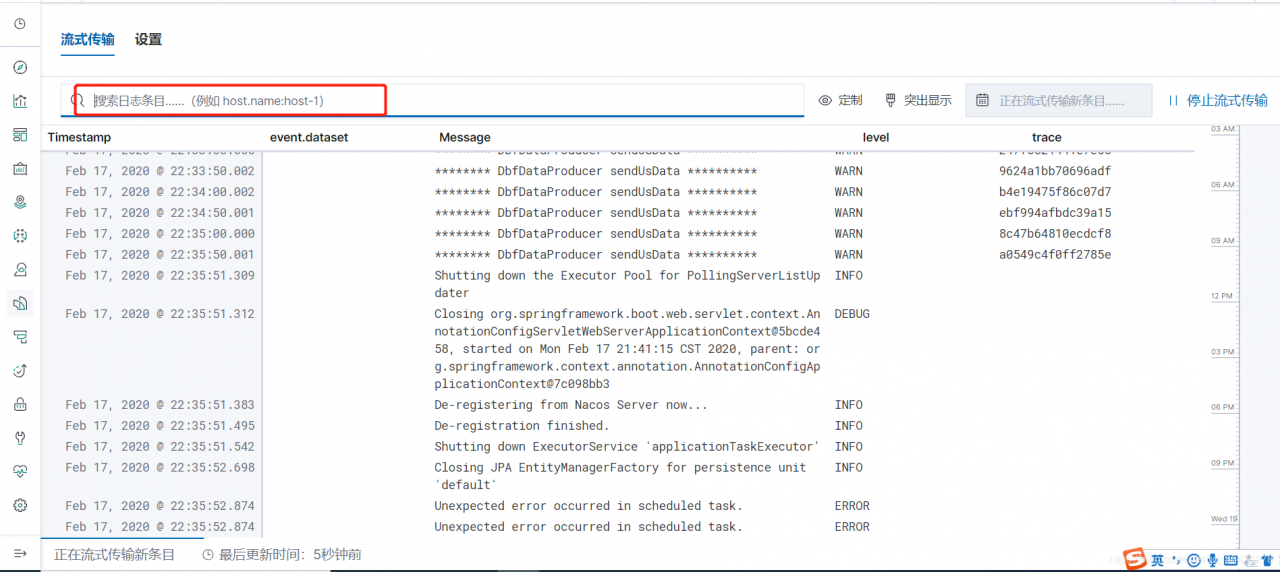

下面截图看下效果:

日志流:

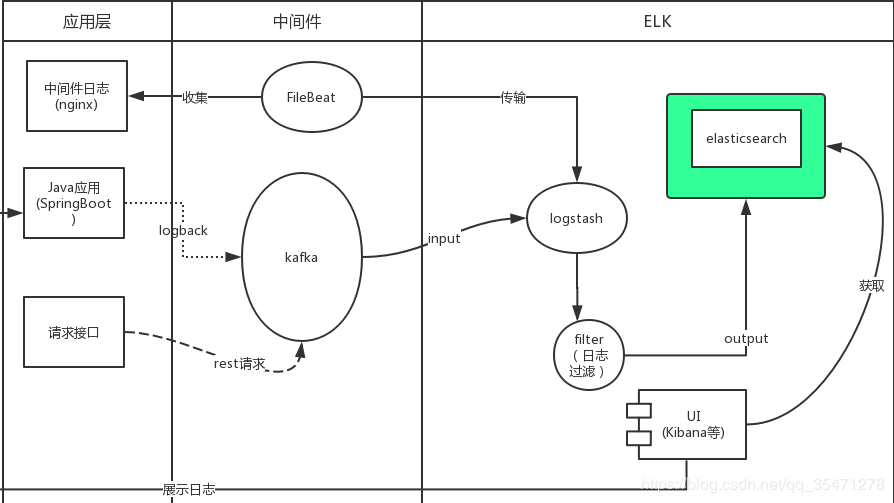

下图是网上找到的流程图:

1.StringBoot通过logback将日志写入到kafka中

2.logstash消费kafka中的消息(日志),经过过滤,输出到elasticsearch

3.最后kibana将elasticsearch收集的日志进行展示

下面详细讲解搭建过程,分成部分

一.环境准备 二 .SpringBoot+logback配置 三.ELK环境搭建 四.kibana使用简单介绍 一.环境准备 1.1检查环境ElasticSearch需要jdk8,官方建议我们使用JDK的版本为1.8.0_131,原文如下:

Elasticsearch requires at least Java 8. Specifically as of this writing, it is recommended that you use the Oracle JDK version 1.8.0_131

检查完毕后,我们可以分别在官网下载对应的组件

ElasticSearch 7.5.2(elk可以在这里下载https://www.elastic.co/cn/downloads/)

Kibana 7.5.2

Logstash 7.5.2

kafka(可以去kafka官网下载,这里不够赘述)

zookeeper(可以使用kafka自带的zk)

在pom中引入

org.springframework.kafka

spring-kafka

com.github.danielwegener

logback-kafka-appender

0.2.0-RC2

net.logstash.logback

logstash-logback-encoder

6.1

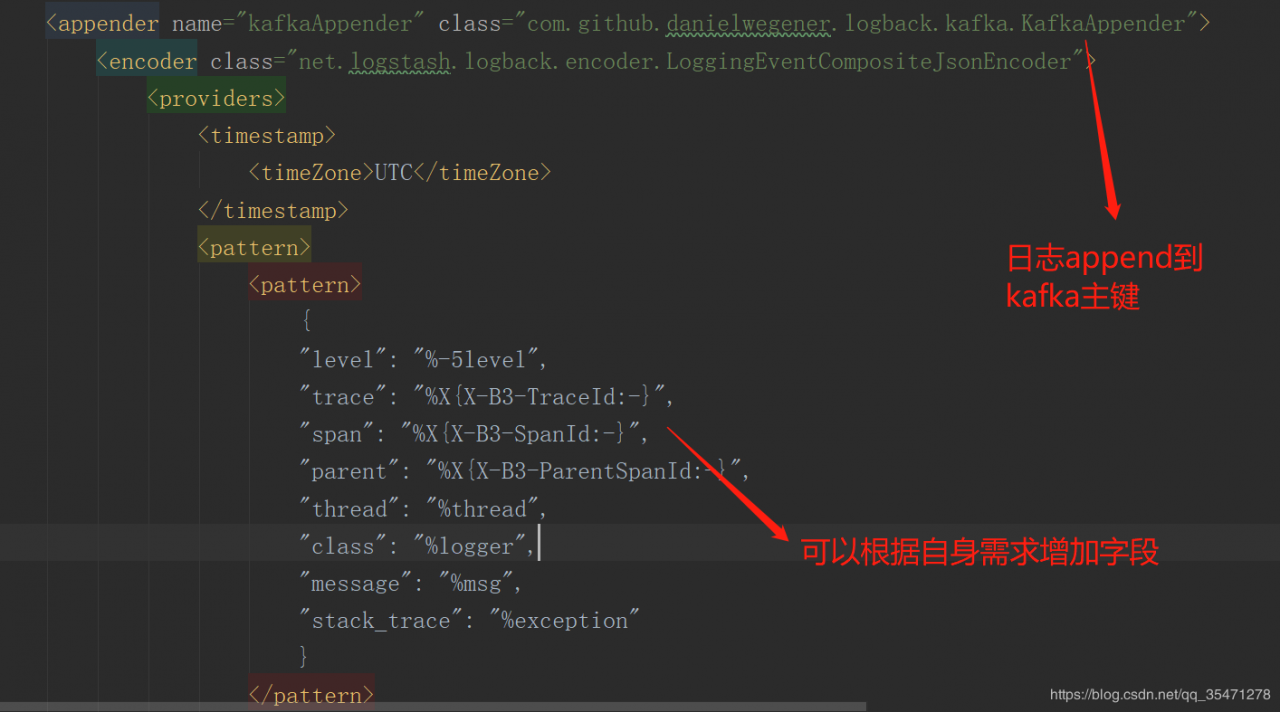

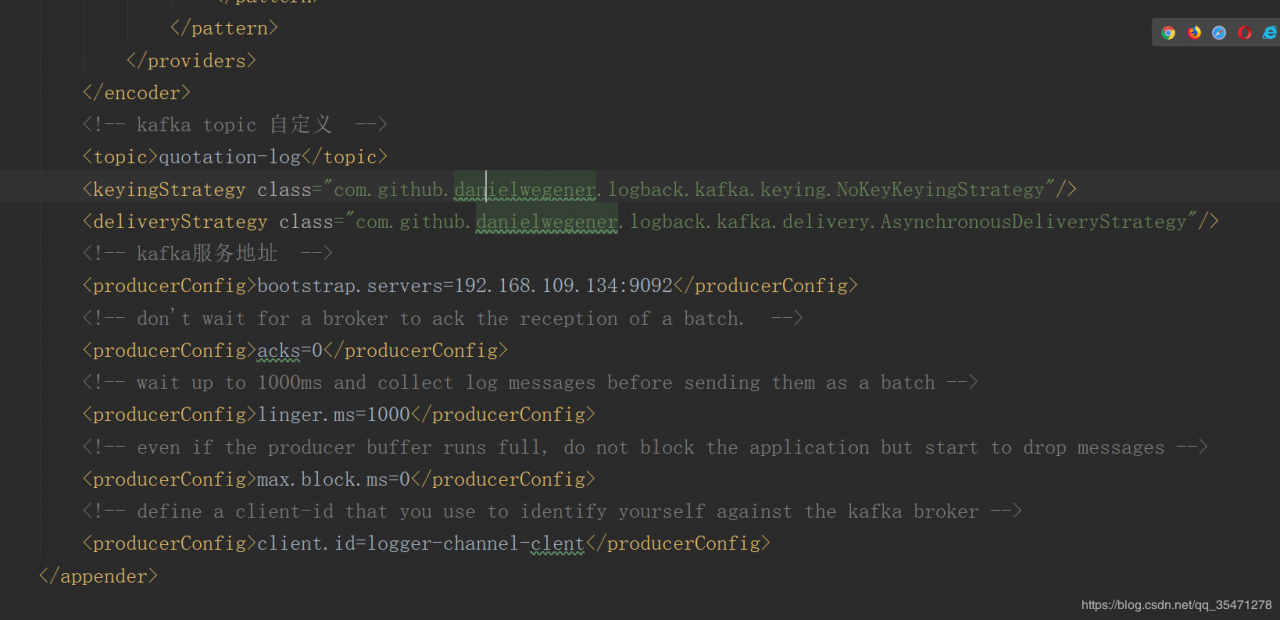

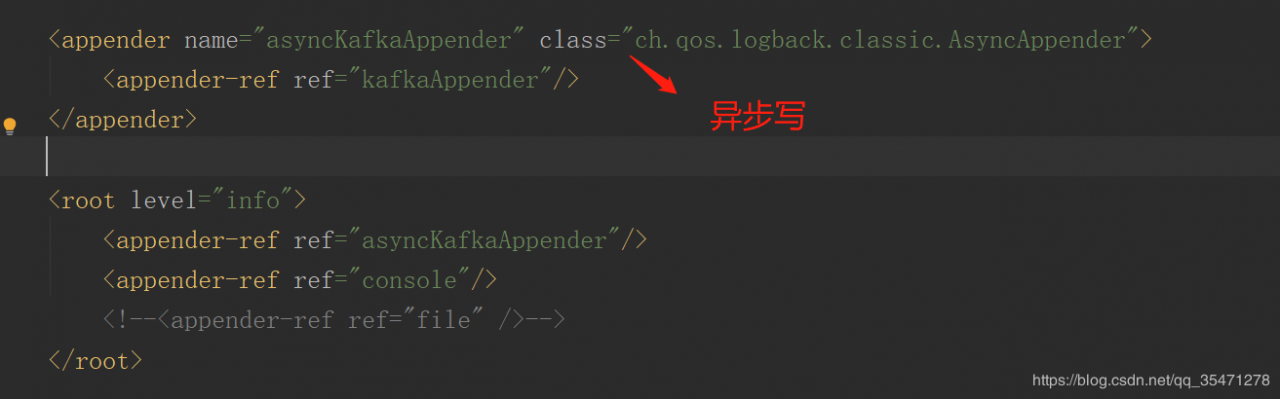

在logback.xml加入下面的配置

这样SpringBoot项目启动后,产生的日志就会写入到kafka中

在官网下载gz包后,解压

进入主目录下的conf目录,创建一个logstash.conf(可以直接复制logstash-sample.conf )

cp logstash-sample.conf logstash.conf

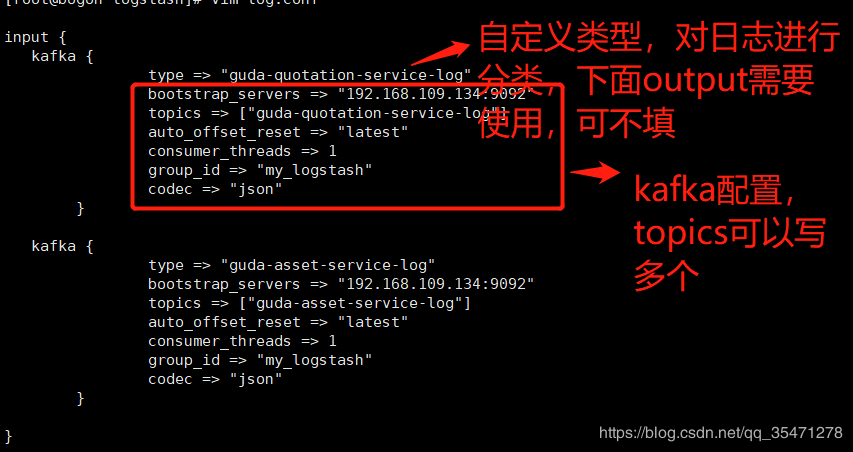

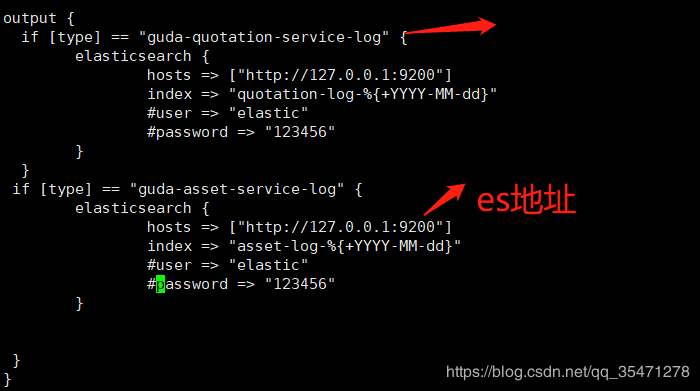

编辑 logstash.conf

vim logstash.conf

加入以下配置

然后启动logstash

./bin/logstash -f config/logstash.conf

解压后进入主目录

打开配置 ,因为不是集群,是单节点所以需要配置

cluster.initial_master_nodes: [“node-1”]

启动es

./bin/elasticsearch

解压后进入主目录

配置 config/kibana.yml

server.host: 192.168.109.134 (本机ip)

elasticsearch.hosts: [“http://localhost:9200”] (es地址)

然后直接启动 kibana

./bin/kibana

kibana启动之后再浏览器打开

http//:ip:5601

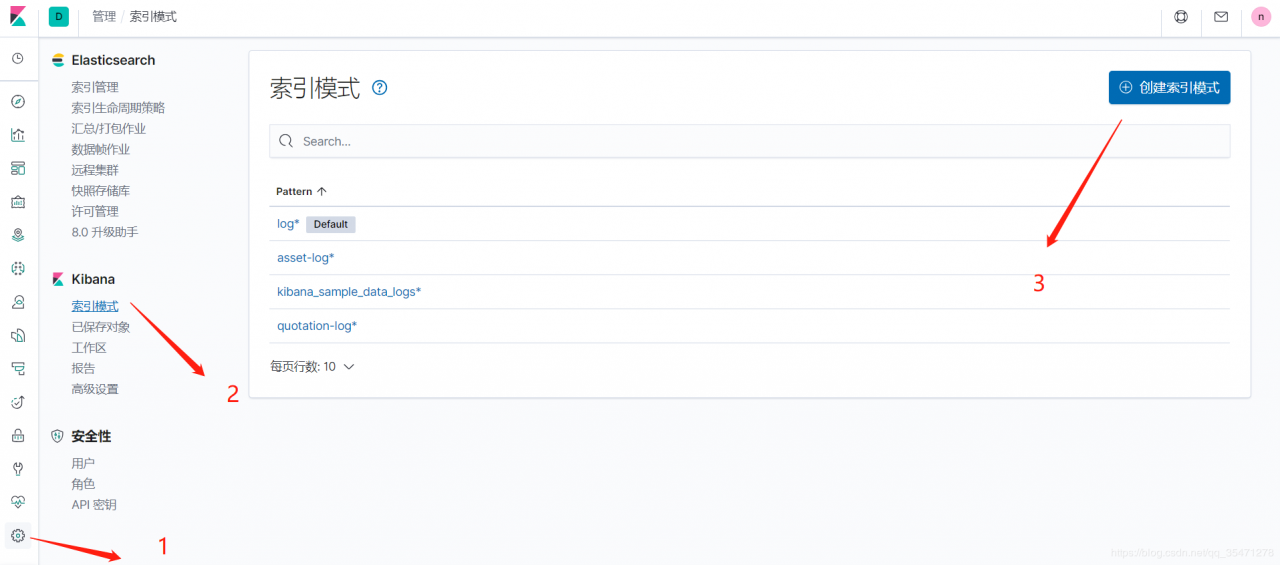

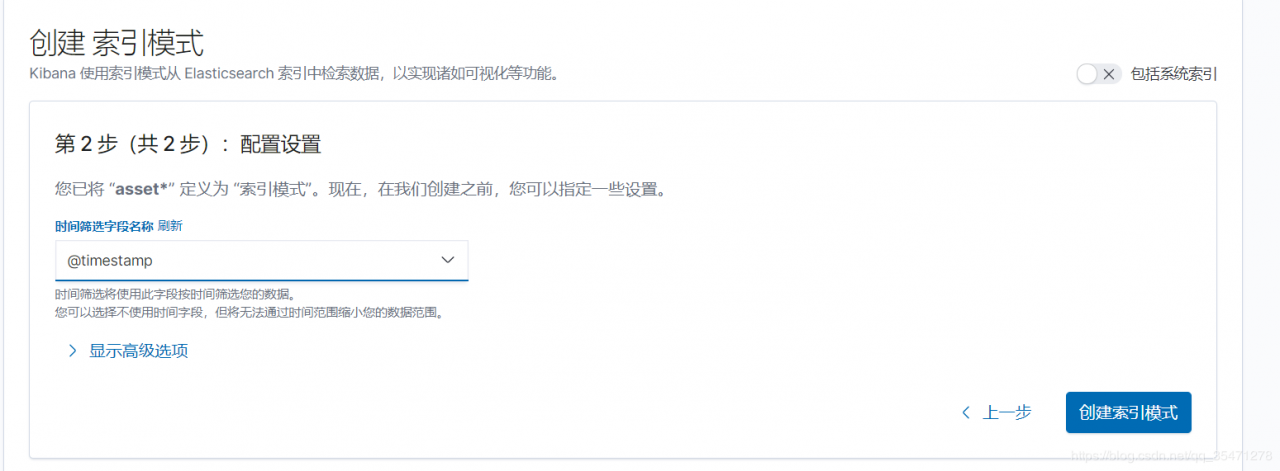

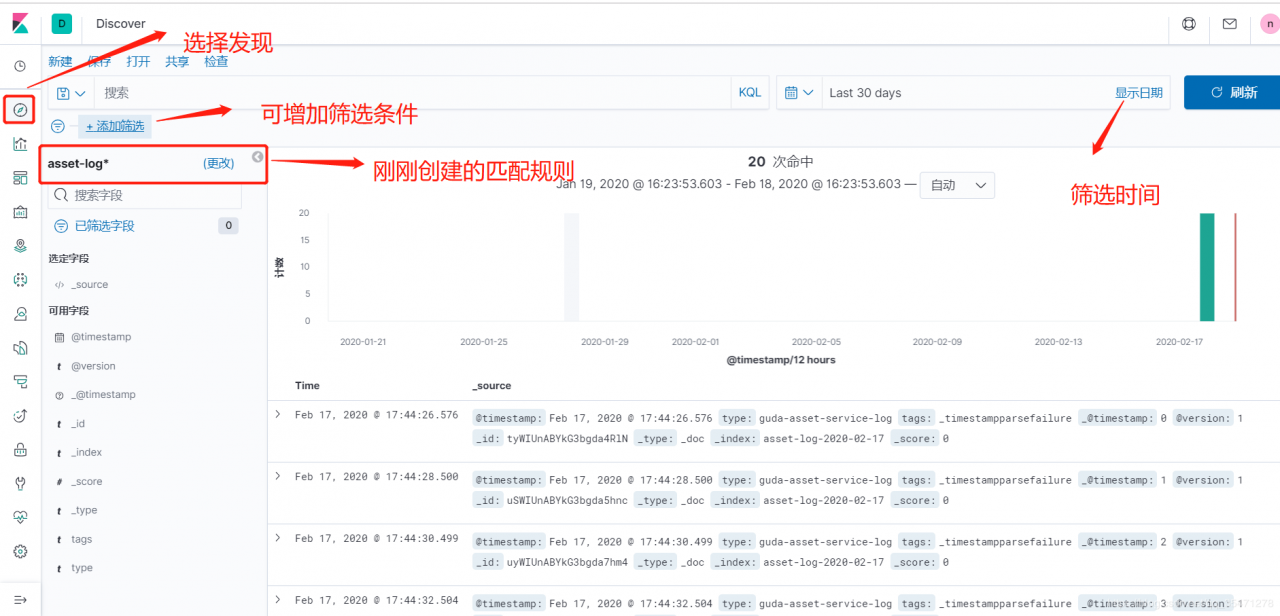

下面演示查看日志

作者:neil_yun