pytorch_task5 卷积神经网络基础;leNet;循环神经网络进阶

本节我们介绍卷积神经网络的基础概念,主要是卷积层和池化层,并解释填充、步幅、输入通道和输出通道的含义。

二维卷积层本节介绍的是最常见的二维卷积层,常用于处理图像数据。

二维卷积层将输入和卷积核做互相关运算,并加上一个标量偏置来得到输出。卷积层的模型参数包括卷积核和标量偏置。

import torch

import torch.nn as nn

def corr2d(X, K):

H, W = X.shape

h, w = K.shape

Y = torch.zeros(H - h + 1, W - w + 1)

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

Y[i, j] = (X[i: i + h, j: j + w] * K).sum()

return Y

class Conv2D(nn.Module):

def __init__(self, kernel_size):

super(Conv2D, self).__init__()

self.weight = nn.Parameter(torch.randn(kernel_size))#使用这个方法自动附上梯度

self.bias = nn.Parameter(torch.randn(1))

def forward(self, x):

return corr2d(x, self.weight) + self.bias

卷积层应用

检测图像中物体的边缘,即找到像素变化的位置

下面我们看一个例子,我们构造一张6,8的图像,中间4列为黑(0),其余为白(1),希望检测到颜色边缘。

构造一个1,2的卷积核K,为[[1,-1]]。

我们的标签是一个6,7的二维数组,第2列是1(从1到0的边缘),第6列是-1(从0到1的边缘)。

X = torch.ones(6, 8)

Y = torch.zeros(6, 7)

X[:, 2: 6] = 0

Y[:, 1] = 1

Y[:, 5] = -1

conv2d = Conv2D(kernel_size=(1, 2))

step = 30

lr = 0.01

for i in range(step):

Y_hat = conv2d(X)

l = ((Y_hat - Y) ** 2).sum()#平方误差比较

l.backward()

# 梯度下降

conv2d.weight.data -= lr * conv2d.weight.grad

conv2d.bias.data -= lr * conv2d.bias.grad

# 梯度清零

conv2d.weight.grad.zero_()

conv2d.bias.grad.zero_()

if (i + 1) % 5 == 0:

print('Step %d, loss %.3f' % (i + 1, l.item()))

print(conv2d.weight.data)

print(conv2d.bias.data)

二维互相关运算

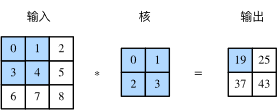

二维互相关(cross-correlation)运算的输入是一个二维输入数组和一个二维核(kernel)数组,输出也是一个二维数组,其中核数组通常称为卷积核或过滤器(filter)。卷积核的尺寸通常小于输入数组,卷积核在输入数组上滑动,在每个位置上,卷积核与该位置处的输入子数组按元素相乘并求和,得到输出数组中相应位置的元素。图1展 示了一个互相关运算的例子,阴影部分分别是输入的第一个计算区域、核数组以及对应的输出。

卷积层得名于卷积运算,但卷积层中用到的并非卷积运算而是互相关运算。我们将核数组上下翻转、左右翻转,再与输入数组做互相关运算,这一过程就是卷积运算。由于卷积层的核数组是可学习的,所以使用互相关运算与使用卷积运算并无本质区别。

特征图与感受野二维卷积层输出的二维数组可以看作是输入在空间维度(宽和高)上某一级的表征,也叫特征图(feature map)。影响元素 x 的前向计算的所有可能输入区域(可能大于输入的实际尺寸)叫做 x 的感受野(receptive field)。

以图1为例,输入中阴影部分的四个元素是输出中阴影部分元素的感受野。我们将图中形状为 2×2 的输出记为 Y ,将 Y 与另一个形状为 2×2 的核数组做互相关运算,输出单个元素 z 。那么, z 在 Y 上的感受野包括 Y 的全部四个元素,在输入上的感受野包括其中全部9个元素。可见,我们可以通过更深的卷积神经网络使特征图中单个元素的感受野变得更加广阔,从而捕捉输入上更大尺寸的特征。

填充和步幅我们介绍卷积层的两个超参数,即填充和步幅,它们可以对给定形状的输入和卷积核改变输出形状。

填充(padding)是指在输入高和宽的两侧填充元素(通常是0元素),图2里我们在原输入高和宽的两侧分别添加了值为0的元素。

作者:2017133130