Mac Spark安装及其IDE使用

https://blog.csdn.net/jiuweiC/article/details/104414651

二、安装scala命令行执行:brew install scala

执行完成后,终端输入:scala -version 进行查看,如下表明安装成功:

scala -version

Scala code runner version 2.12.8 -- Copyright 2002-2018, LAMP/EPFL and Lightbend, Inc.

然后在环境变量中增加scala相关的变量,命令行输入:vim ~/etc/profile进行编辑,增加环境变量:

export SCALA_HOME=/usr/local/Cellar/scala/2.12.8

export PATH=$PATH:$SCALA_HOME/bin

三、安装spark

1、安装spark

进入Apache Spark官网进行Spark的下载:http://spark.apache.org/downloads.html

下载完之后解压,并将解压后将文件夹名称改为 spark ,

的文件夹移动到/usr/local/目录下

2、 配置环境变量

命令行输入:vim ~/etc/profile进行编辑,增加环境变量:

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/bin

然后保存退出,执行source ~/etc/profile,使之生效。

5.3 配置spark-env.sh

进入到Spark目录的conf配置文件中:cd /usr/local/spark/conf,执行命令:cp spark-env.sh.template spark-env.sh将spark-env.sh.template拷贝一份,然后打开拷贝后的spark-env.sh文件:vim spark-env.sh,在里面加入如下内容:

export SCALA_HOME=/usr/local/Cellar/scala/2.12.6

export SPARK_MASTER_IP=localhost

export SPARK_WORKER_MEMORY=4G

配置好之后,命令行执行:spark-shell,如果出现如下所示的画面,就表明spark安装成功了:

四、IDE开发

1.官网下载intellij

jetbrains.com/idea/

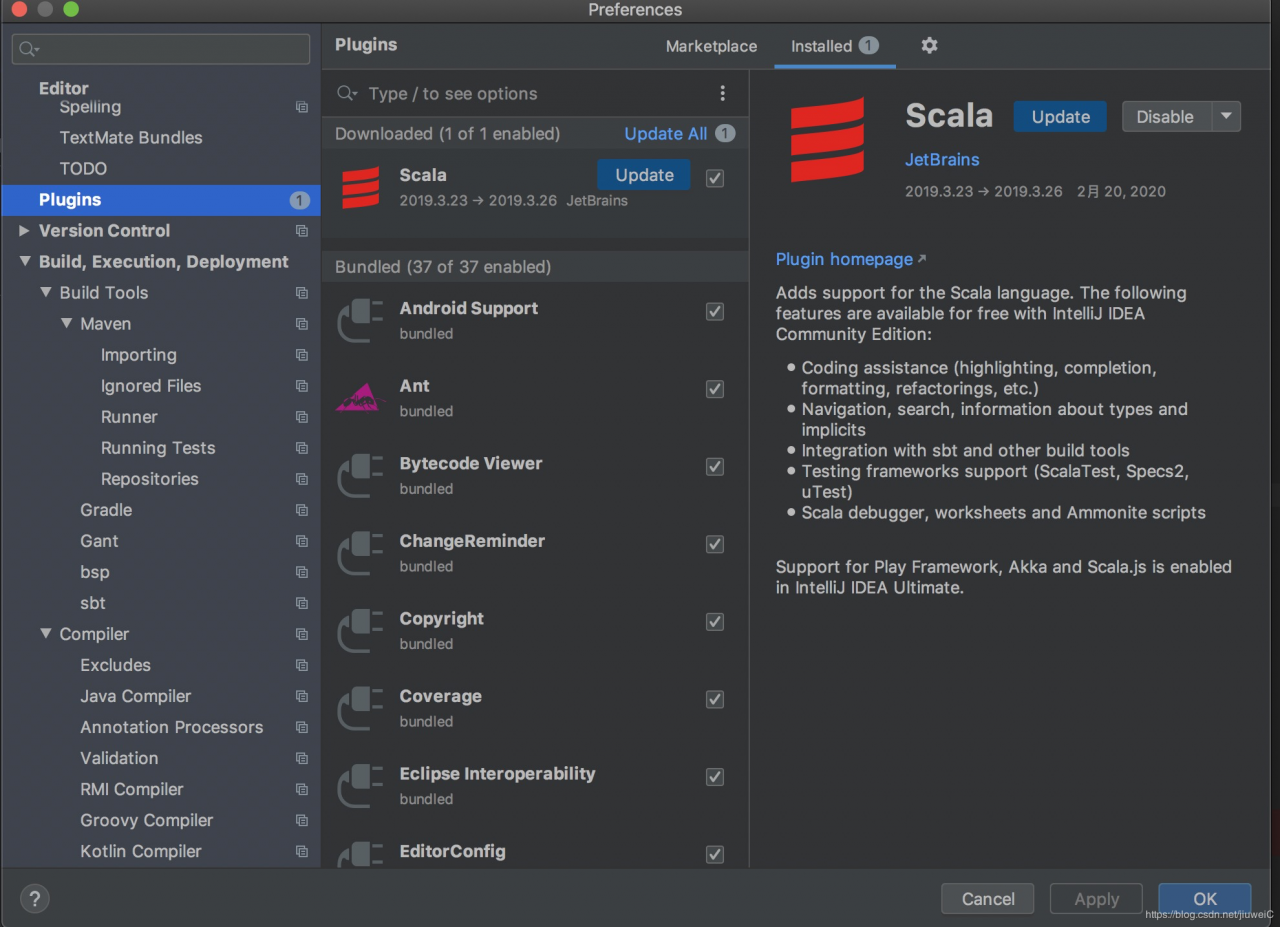

2.安装scala插件

安装时顺便安装scala插件,如果当时没有安装

preference->Plugins 安装scala重启ide

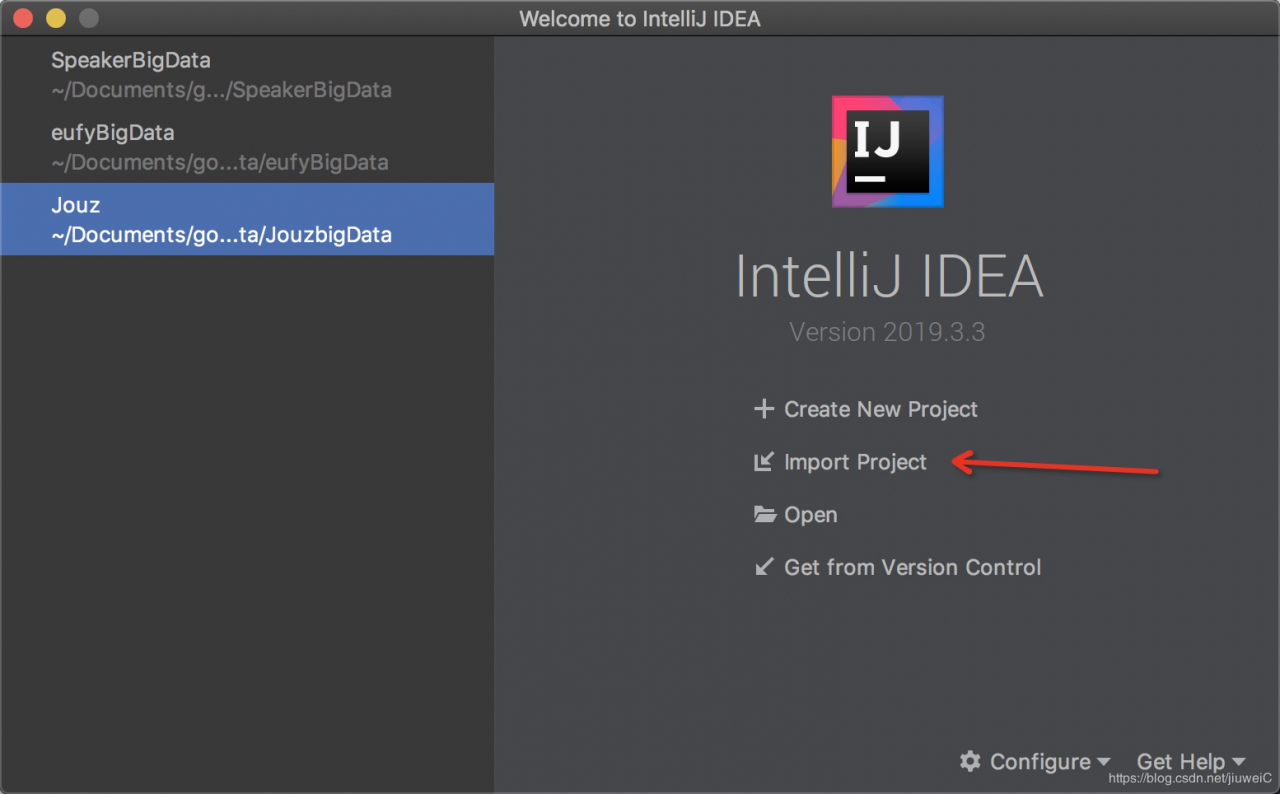

3.导入项目

选择导入项目

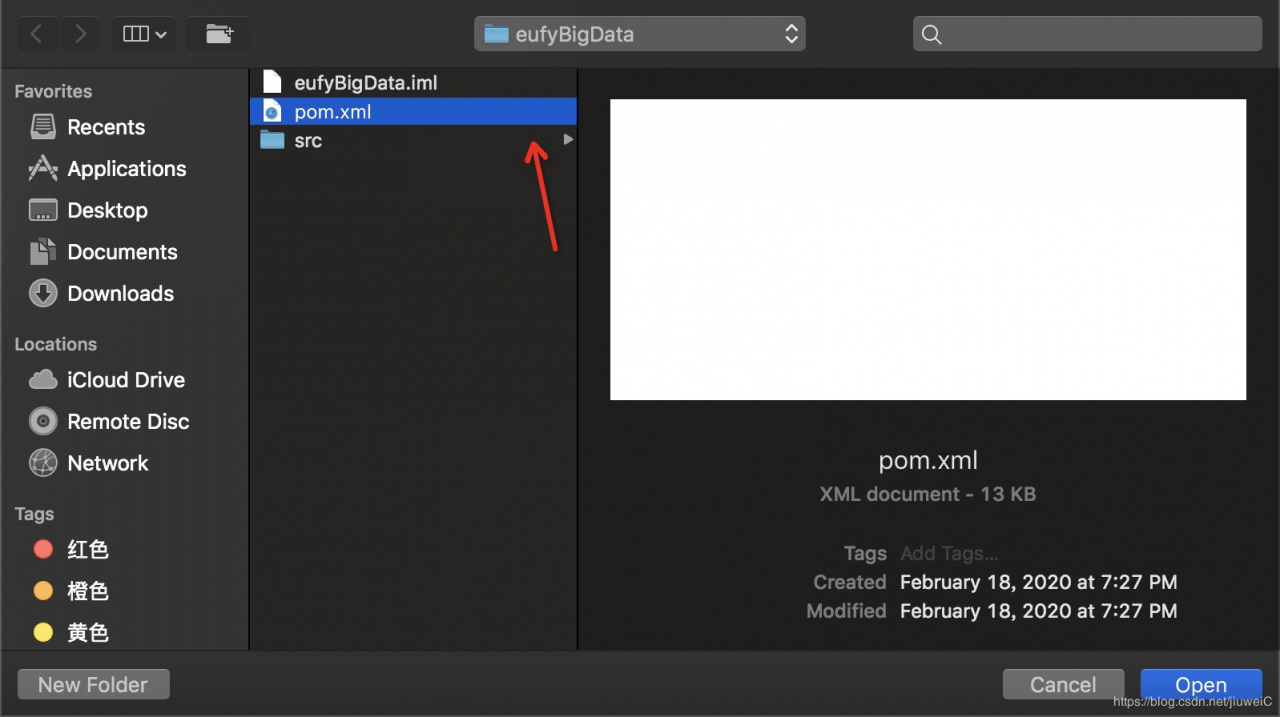

选择项目的pom文件进行打开

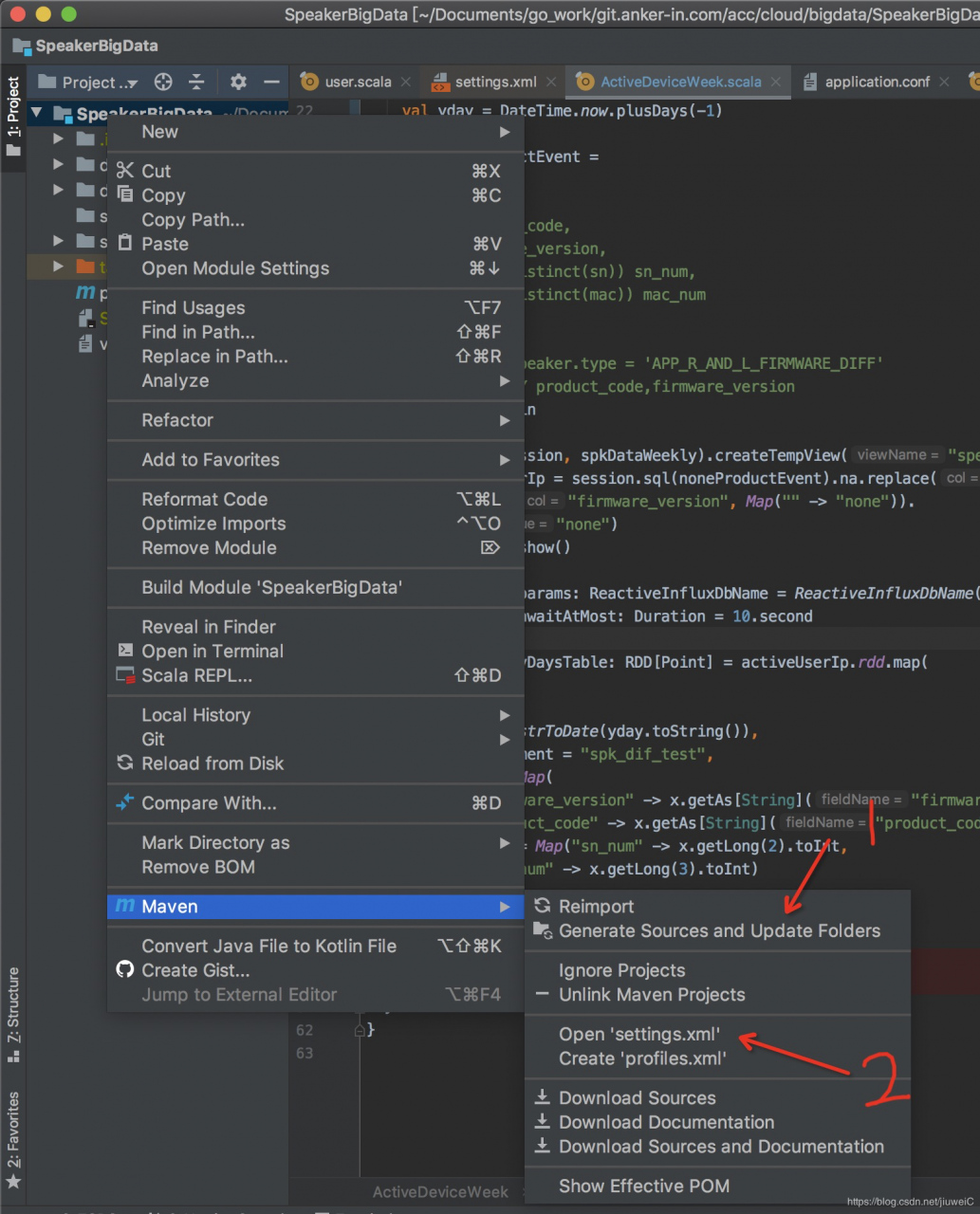

导入依赖,右键maven->选择第一项

如果你是国内的网,请先点击2,配置国内镜像,这里给出ali镜像

alimaven

aliyun maven

http://maven.aliyun.com/nexus/content/groups/public/

central

作者:jiuweiC