20200322零基础入门数据挖掘 - 二手车交易价格预测笔记(2)

二、EDA-数据探索性分析

网上有说法是,python出现warnings通常是提示用户一些错误或者过时的用法,也有时候是因为导入的第三方API有些功能是python不赞成的,但并不会影响运行,故而忽略警告语句能让界面更加清爽,不会时不时报错。 Pandas和Numpy数据科学库的作用?

Pandas是基于NumPy数组构建的,使数据预处理、清洗、分析工作变得更快更简单。pandas是专门为处理表格和混杂数据设计的,而NumPy更适合处理统一的数值数组数据。pandas有两个主要数据结构:Series和DataFrame。NumPy函数库则是Python的一种开源的数值计算扩展工具,能够处理矩阵的数据类型。

from Python pandas用法 Matplotlib和Seaborn的作用?

Matplotlib相当于Python的绘图库,它与 NumPy一起使用,提供了一种有效的 MatLab开源替代方案。Seaborn是基于matplotlib的图形可视化python包。它提供了一种高度交互式界面,便于用户能够做出各种有吸引力的统计图表。

from Seaborn简单介绍 missingno的作用?

可以做缺失值的可视化处理,可以快速直观地总结数据集的完整性。

from 缺失值可视化处理–missingno 2.4判断数据缺失和异常知识点(2.2和2.3操作没有太多的问题,时间原因先跳过)

分为类别特征和数字特征进行处理,并对类别特征查看unique分布,题目中需要进行人为分类。不过此处我还未理解匿名特征属于numeric,可能是因为前面对数据类型的判断是float?(理解后再更新)

利用箱线图判断数据的偏态和尾重:

对于标准正态分布的样本,只有极少值为异常值。异常值越多说明尾部越重,自由度越小(即自由变动的量的个数);而偏态表示偏离程度,异常值集中在较小值一侧,则分布呈左偏态;异常值集中在较大值一侧,则分布呈右偏态。

小提琴图由五个数值点组成:最小值(min),下四分位数(Q1)中位数(median),上四分位数(Q3),最大值(max),也可以往里面加入平均值(mean)。

作者:zjlingdi

前面的步骤就不做赘述了,我在下载好资料后,在jupyter notebook里将数据导入,随后进行课程内容的一系列指导操作,熟悉数据集,包括:

2.1 载入各种数据科学以及可视化库: 数据科学库 pandas、numpy、scipy; 可视化库 matplotlib、seabon; 其他; 2.2 载入数据: 载入训练集和测试集; 简略观察数据**(head()+shape)**; 2.3 数据总览: 通过**describe()**来熟悉数据的相关统计量 通过**info()**来熟悉数据类型 2.4 判断数据缺失和异常 查看每列的存在nan情况 异常值检测 2.5 了解预测值的分布 总体分布概况(无界约翰逊分布等) 查看skewness and kurtosis 查看预测值的具体频数 2.6 特征分为类别特征和数字特征,并对类别特征查看unique分布 2.7 数字特征分析 相关性分析 查看几个特征得 偏度和峰值 每个数字特征得分布可视化 数字特征相互之间的关系可视化 多变量互相回归关系可视化 2.8 类型特征分析 unique分布 类别特征箱形图可视化 类别特征的小提琴图可视化 类别特征的柱形图可视化类别 特征的每个类别频数可视化(count_plot) 2.9 用pandas_profiling生成数据报告 2.10代码运行过程 2.1载入各种数据科学以及可视化库知识点#coding:utf-8

#导入warnings包,利用过滤器来实现忽略警告语句。

import warnings

warnings.filterwarnings('ignore')

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

import missingno as msno

整个操作过程中也在不断产生疑问,并寻找解答:

为什么要导入warnings包去忽略警告语句?网上有说法是,python出现warnings通常是提示用户一些错误或者过时的用法,也有时候是因为导入的第三方API有些功能是python不赞成的,但并不会影响运行,故而忽略警告语句能让界面更加清爽,不会时不时报错。 Pandas和Numpy数据科学库的作用?

Pandas是基于NumPy数组构建的,使数据预处理、清洗、分析工作变得更快更简单。pandas是专门为处理表格和混杂数据设计的,而NumPy更适合处理统一的数值数组数据。pandas有两个主要数据结构:Series和DataFrame。NumPy函数库则是Python的一种开源的数值计算扩展工具,能够处理矩阵的数据类型。

from Python pandas用法 Matplotlib和Seaborn的作用?

Matplotlib相当于Python的绘图库,它与 NumPy一起使用,提供了一种有效的 MatLab开源替代方案。Seaborn是基于matplotlib的图形可视化python包。它提供了一种高度交互式界面,便于用户能够做出各种有吸引力的统计图表。

from Seaborn简单介绍 missingno的作用?

可以做缺失值的可视化处理,可以快速直观地总结数据集的完整性。

from 缺失值可视化处理–missingno 2.4判断数据缺失和异常知识点(2.2和2.3操作没有太多的问题,时间原因先跳过)

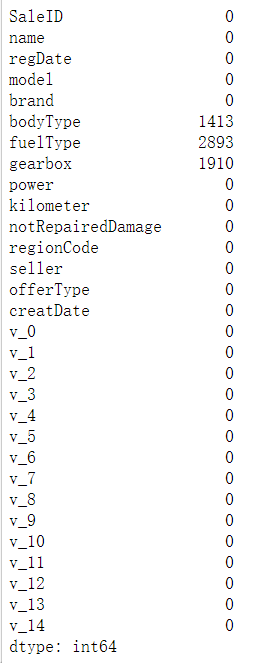

# 1)查看每列的存在nan情况

Test_data.isnull().sum()

通过上方的式子可知每列存在缺失值的情况,主要是集中在bodyType,fuelType和gearbox这几列,可以通过missingno进行可视化处理。

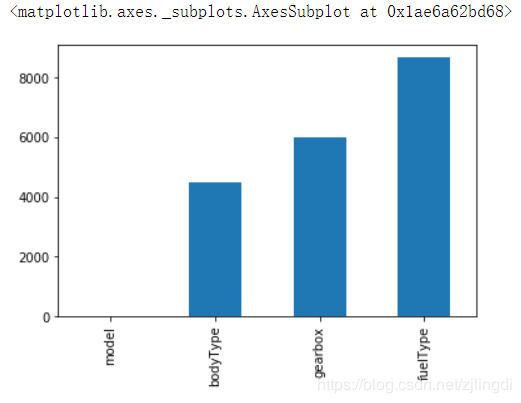

# nan可视化

missing = Train_data.isnull().sum()

missing = missing[missing > 0]

missing.sort_values(inplace=True)

missing.plot.bar()

Tip:这一个步骤的目的主要是看nan存在的个数是否真的很大,如果很小一般选择填充,如果使用lgb等树模型可以直接空缺,让树自己去优化,但如果nan存在的过多、可以考虑删掉。

# 可视化看下缺省值

msno.matrix(Train_data.sample(250))

#Train_data表示类型为dataframe的表格,sample(250)表示抽取表格中250个样本。

msno.bar(Train_data.sample(1000))

# 可视化看下缺省值

msno.matrix(Test_data.sample(250))

# 白线越多,代表缺失值越多。

msno.bar(Test_data.sample(1000))

这四条式子依然是在看数据集里面的缺省值,可以发现测试集的缺省和训练集的差不多情况, 可视化有四列有缺省,而notRepairedDamage缺省得最多。

## 2) 查看异常值检测

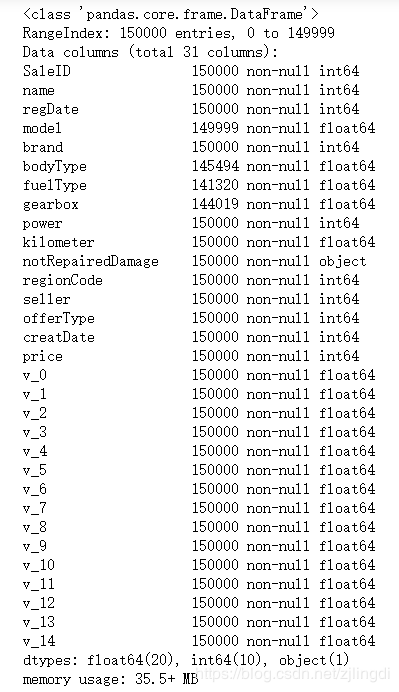

Train_data.info()

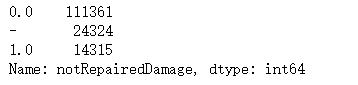

根据运行结果可知,只有notRepairedDamage是object格式,所以会再去看notRepairedDamage这列里面具体是出现哪些值,出现多少次。

Train_data['notRepairedDamage'].value_counts()

经过此步骤找到了异常值“-”,因为很多模型对nan有直接的处理,所以此处就先替换成nan。

Train_data['notRepairedDamage'].replace('-', np.nan, inplace=True)

处理完缺省值和异常值的问题,那么接下来就是看测试集里面价格的分布,也就是我们最终要预测的值,模型也是要依照这个分布而定的。

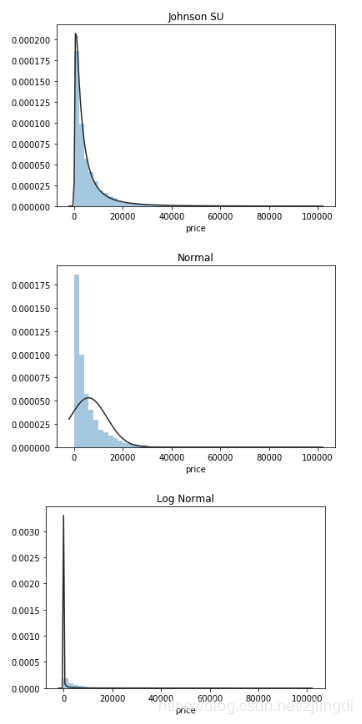

2.5了解预测值的分布知识点## 1) 总体分布概况(无界约翰逊分布等)

import scipy.stats as st

y = Train_data['price']

plt.figure(1); plt.title('Johnson SU')

sns.distplot(y, kde=False, fit=st.johnsonsu)

plt.figure(2); plt.title('Normal')

sns.distplot(y, kde=False, fit=st.norm)

plt.figure(3); plt.title('Log Normal')

sns.distplot(y, kde=False, fit=st.lognorm)

从这一步骤的运行结果来看,线条与蓝色分布最拟合的就是第一张图,无界约翰逊分布。

分为类别特征和数字特征进行处理,并对类别特征查看unique分布,题目中需要进行人为分类。不过此处我还未理解匿名特征属于numeric,可能是因为前面对数据类型的判断是float?(理解后再更新)

numeric_features = ['power', 'kilometer', 'v_0', 'v_1', 'v_2', 'v_3', 'v_4', 'v_5', 'v_6', 'v_7', 'v_8', 'v_9', 'v_10', 'v_11', 'v_12', 'v_13','v_14' ]

categorical_features = ['name', 'model', 'brand', 'bodyType', 'fuelType', 'gearbox', 'notRepairedDamage', 'regionCode',]

2.7数字特征分析知识点

一般会拿偏度和峰度来看数据的分布形态,而且一般会跟正态分布做比较,我们把正态分布的偏度和峰度都看做零。如果我们在实操中,算到偏度峰度不为0,即表明变量存在左偏右偏,或者是高顶平顶这么一说。

## 查看几个特征得 偏度和峰值

for col in numeric_features:

print('{:15}'.format(col),

'Skewness: {:05.2f}'.format(Train_data[col].skew()) ,

' ' ,

'Kurtosis: {:06.2f}'.format(Train_data[col].kurt())

)

2.8类别特征分析知识点

掌握unique分布

## 1) unique分布

for fea in categorical_features:

print(Train_data[fea].nunique())

掌握箱型图、小提琴图的分析利用箱线图判断数据的偏态和尾重:

对于标准正态分布的样本,只有极少值为异常值。异常值越多说明尾部越重,自由度越小(即自由变动的量的个数);而偏态表示偏离程度,异常值集中在较小值一侧,则分布呈左偏态;异常值集中在较大值一侧,则分布呈右偏态。

小提琴图由五个数值点组成:最小值(min),下四分位数(Q1)中位数(median),上四分位数(Q3),最大值(max),也可以往里面加入平均值(mean)。

作者:zjlingdi

相关文章

Fidelia

2021-05-09

Odetta

2020-04-17

Psyche

2023-07-20

Winola

2023-07-20

Gella

2023-07-20

Grizelda

2023-07-20

Janna

2023-07-20

Ophelia

2023-07-21

Crystal

2023-07-21

Laila

2023-07-21

Aine

2023-07-21

Bliss

2023-07-21

Lillian

2023-07-21

Tertia

2023-07-21

Olive

2023-07-21

Angie

2023-07-21

Nora

2023-07-24