动手学深度学习(PyTorch实现)(八)--AlexNet模型

AlexNet模型1. AlexNet模型介绍1.1 AlexNet的特点1.2 AlexNet的结构1.3 AlexNet参数数量2. AlexNet的PyTorch实现2.1 导入相应的包2.2 构建AlexNet网络2.3 加载数据集2.4 训练网络

1. AlexNet模型介绍

卷积层 C2,C4,C5中的卷积核只和位于同一GPU的上一层的FeatureMap相连。从上面可以看出,参数大多数集中在全连接层,在卷积层由于权值共享,权值参数较少。 2. AlexNet的PyTorch实现 2.1 导入相应的包

作者:爱吃骨头的猫、

由于受到计算机性能的影响,虽然LeNet在图像分类中取得了较好的成绩,但是并没有引起很多的关注。 直到2012年,Alex等人提出的AlexNet网络在ImageNet大赛上以远超第二名的成绩夺冠,卷积神经网络乃至深度学习重新引起了广泛的关注。AlexNet首次证明了学习到的特征可以超越⼿⼯设计的特征,从而⼀举打破计算机视觉研究的前状。

1.1 AlexNet的特点AlexNet是在LeNet的基础上加深了网络的结构,学习更丰富更高维的图像特征。AlexNet的特点:

更深的网络结构 使用层叠的卷积层,即卷积层+卷积层+池化层来提取图像的特征 使用Dropout抑制过拟合 使用数据增强Data Augmentation抑制过拟合 使用Relu替换之前的sigmoid的作为激活函数 多GPU训练 1.2 AlexNet的结构AlexNet的结构为:

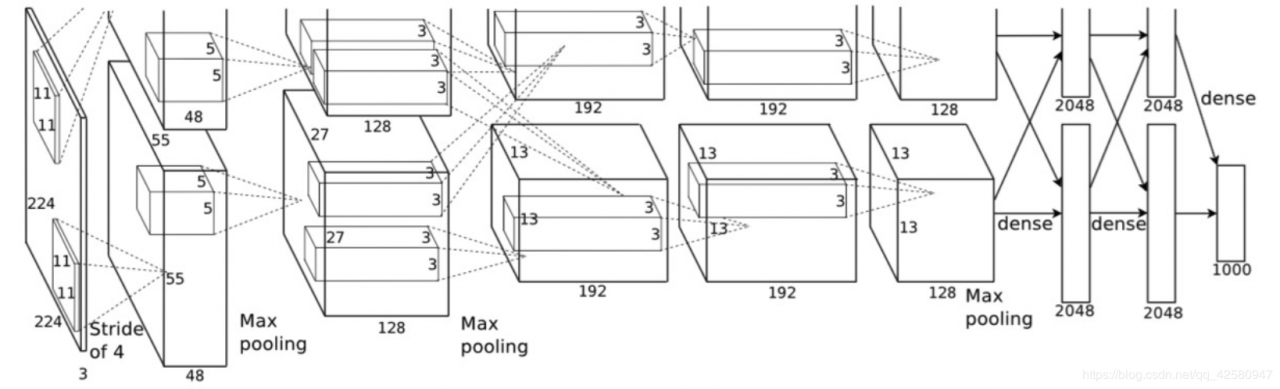

上图是论文中的原图,比较复杂,不容易看清楚,下图是更清晰的结构图:

网络包含8个带权重的层;前5层是卷积层,剩下的3层是全连接层。最后一层全连接层的输出是1000维softmax的输入,softmax会产生1000类标签的分布网络包含8个带权重的层;前5层是卷积层,剩下的3层是全连接层。最后一层全连接层的输出是1000维softmax的输入,softmax会产生1000类标签的分布。

卷积层的参数 = 卷积核的数量 * 卷积核 + 偏置

C1: 96个11×11×3的卷积核,96×11×11×3+96=34848 C2: 2组,每组128个5×5×48的卷积核,(128×5×5×48+128)×2=307456 C3: 384个3×3×256的卷积核,3×3×256×384+384=885120 C4: 2组,每组192个3×3×192的卷积核,(3×3×192×192+192)×2=663936 C5: 2组,每组128个3×3×192的卷积核,(3×3×192×128+128)×2=442624 FC6: 4096个6×6×256的卷积核,6×6×256×4096+4096=37752832 FC7: 4096∗4096+4096=16781312 output: 4096∗1000=4096000卷积层 C2,C4,C5中的卷积核只和位于同一GPU的上一层的FeatureMap相连。从上面可以看出,参数大多数集中在全连接层,在卷积层由于权值共享,权值参数较少。 2. AlexNet的PyTorch实现 2.1 导入相应的包

import time

import torch

from torch import nn, optim

import torchvision

import numpy as np

import sys

sys.path.append("/home/kesci/input/")

import d2lzh1981 as d2l

import os

import torch.nn.functional as F

2.2 构建AlexNet网络

# 如果有GPU,开启GPU

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

class AlexNet(nn.Module):

def __init__(self):

super(AlexNet, self).__init__()

self.conv = nn.Sequential(

# in_channels, out_channels, kernel_size, stride, padding

nn.Conv2d(1, 96, 11, 4),

nn.ReLU(),

# kernel_size, stride

nn.MaxPool2d(3, 2),

# 减小卷积窗口,使用填充为2来使得输入与输出的高和宽一致,且增大输出通道数

nn.Conv2d(96, 256, 5, 1, 2),

nn.ReLU(),

nn.MaxPool2d(3, 2),

# 连续3个卷积层,且使用更小的卷积窗口。除了最后的卷积层外,进一步增大了输出通道数。

# 前两个卷积层后不使用池化层来减小输入的高和宽

nn.Conv2d(256, 384, 3, 1, 1),

nn.ReLU(),

nn.Conv2d(384, 384, 3, 1, 1),

nn.ReLU(),

nn.Conv2d(384, 256, 3, 1, 1),

nn.ReLU(),

nn.MaxPool2d(3, 2)

)

# 这里全连接层的输出个数比LeNet中的大数倍。使用丢弃层来缓解过拟合

self.fc = nn.Sequential(

nn.Linear(256*5*5, 4096),

nn.ReLU(),

nn.Dropout(0.5),

#由于使用CPU镜像,精简网络,若为GPU镜像可添加该层

#nn.Linear(4096, 4096),

#nn.ReLU(),

#nn.Dropout(0.5),

# 输出层。由于这里使用Fashion-MNIST,所以用类别数为10,而非论文中的1000

nn.Linear(4096, 10),

)

def forward(self, img):

feature = self.conv(img)

output = self.fc(feature.view(img.shape[0], -1))

return output

# 新建AlexNet网络

net = AlexNet()

2.3 加载数据集

# 加载Fashion MNIST数据集

def load_data_fashion_mnist(batch_size, resize=None, root='/home/kesci/input/FashionMNIST2065'):

"""Download the fashion mnist dataset and then load into memory."""

trans = []

if resize:

trans.append(torchvision.transforms.Resize(size=resize))

trans.append(torchvision.transforms.ToTensor())

transform = torchvision.transforms.Compose(trans)

mnist_train = torchvision.datasets.FashionMNIST(root=root, train=True, download=True, transform=transform)

mnist_test = torchvision.datasets.FashionMNIST(root=root, train=False, download=True, transform=transform)

train_iter = torch.utils.data.DataLoader(mnist_train, batch_size=batch_size, shuffle=True, num_workers=2)

test_iter = torch.utils.data.DataLoader(mnist_test, batch_size=batch_size, shuffle=False, num_workers=2)

return train_iter, test_iter

batch_size = 16

# 如出现“out of memory”的报错信息,可减小batch_size或resize

train_iter, test_iter = load_data_fashion_mnist(batch_size,224)

2.4 训练网络

lr, num_epochs = 0.001, 3

optimizer = torch.optim.Adam(net.parameters(), lr=lr)

# .train_ch5()函数在LeNet模型中已经定义,不在重复定义

d2l.train_ch5(net, train_iter, test_iter, batch_size, optimizer, device, num_epochs)

作者:爱吃骨头的猫、

相关文章

Francesca

2021-01-26

Iris

2021-08-03

Cynthia

2020-09-01

Floria

2021-01-03

Tani

2023-05-27

Tanisha

2023-05-27

Kande

2023-05-27

Tricia

2023-05-27

Pandora

2023-07-07

Tallulah

2023-07-17

Janna

2023-07-20

Ophelia

2023-07-20

Natalia

2023-07-20

Xylona

2023-07-20

Radinka

2023-07-20

Dorothy

2023-07-20

Irma

2023-07-20