cs224n nlp小记

distributional semantics:

A word’s meaning is given by the words that frequently appear close-by

Word Vectors(word embedding/ word representation): distributed representation

Word2vec is a framework for learning word vectors

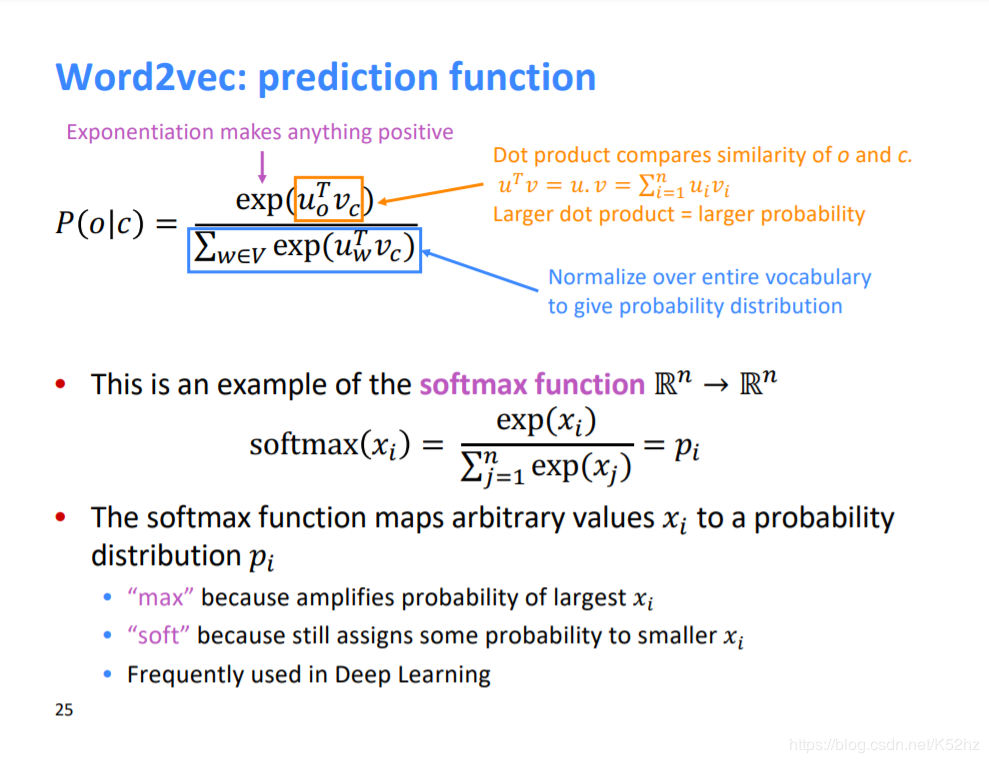

softmax在nlp中的应用:

相似性度量 分母normalize over entire vocabulary to give probalibity distribution 使用exp函数,相对大小不变,但是可以将负数表示成正数,方便概率的表示softmax含义:

soft:使用了exp,对于其他小的类别仍然给予了一定概率。 because still assigns some probability to smaller xi max: because amplifies probability of largest xi

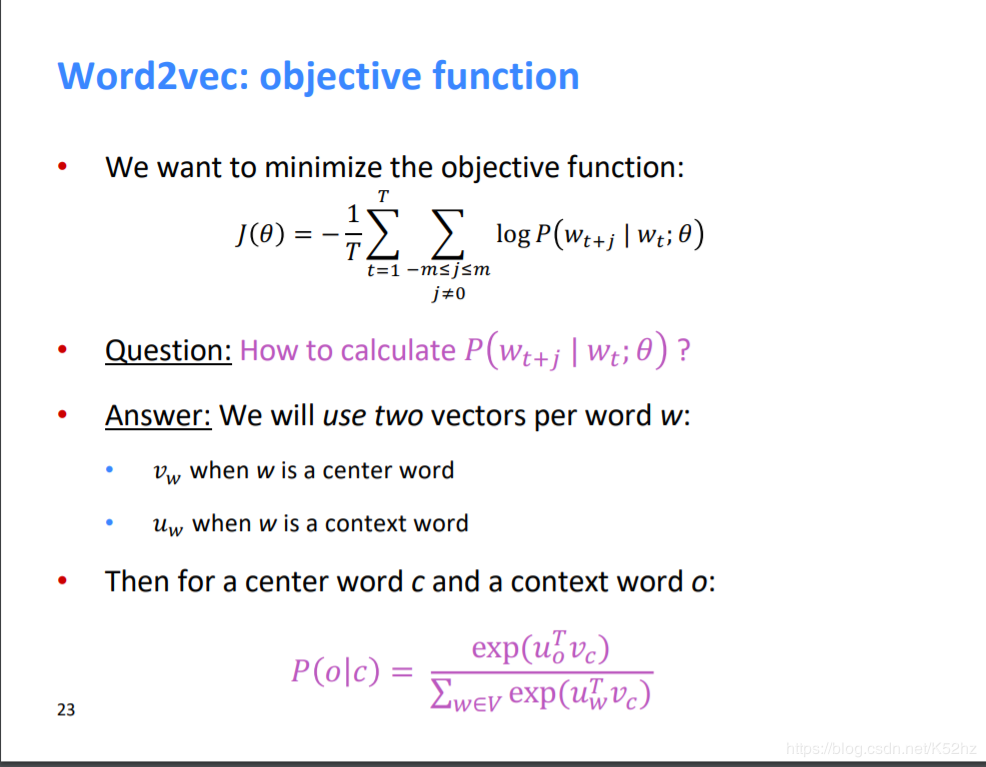

损失函数使用-log的原因:

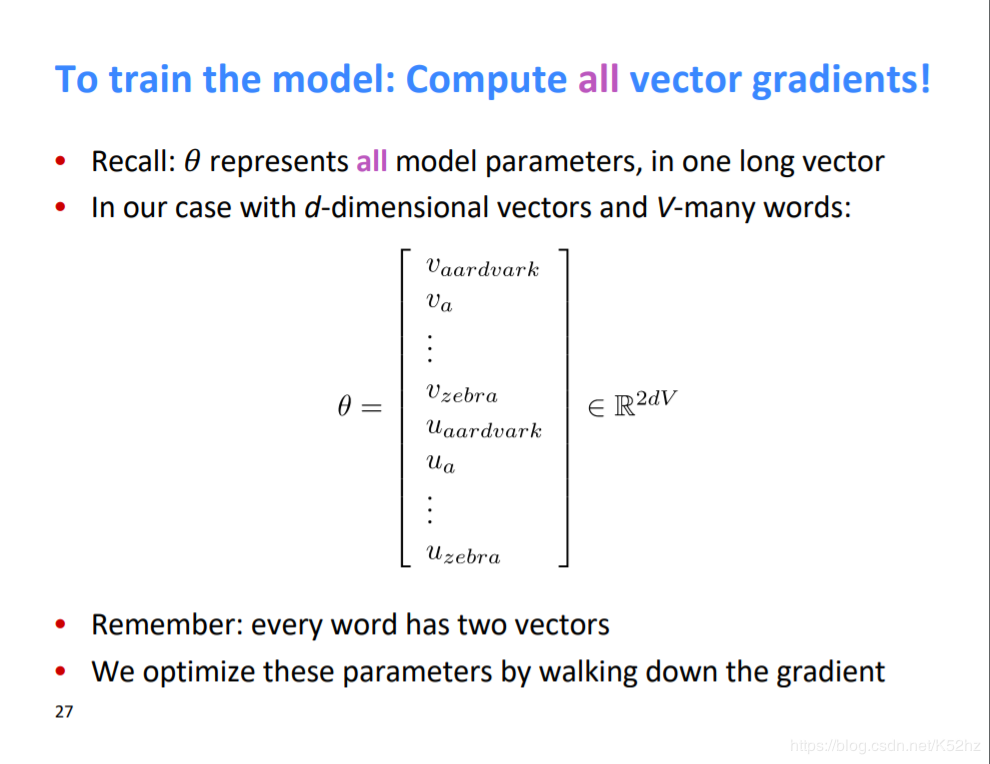

使用负号:使得最大化问题转换为loss最小化问题 使用log:概率越接近1损失越小,概率等于1损失为0参数数量以及参数是什么:

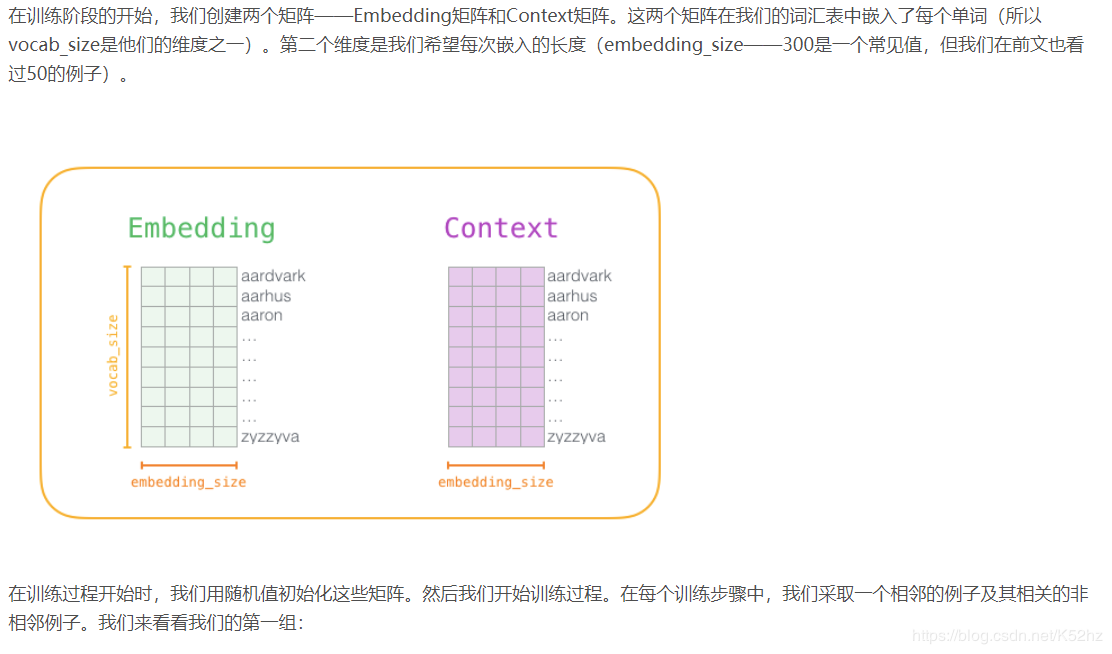

两个矩阵:embedding和context,随机初始化字典中所有单词的embedding

参考链接:https://blog.csdn.net/han_xiaoyang/article/details/89082129

作者:imapotato