动手学习深度学习(Pytorch版)Task 3:过拟合欠拟合及其解决方案和梯度消失、梯度爆炸学习总结

过拟合和欠拟合是模型训练中经常出现的两类典型问题。在实践中,我们要尽可能同时应对欠拟合和过拟合。虽然有很多因素可能导致这两种拟合问题,但在这里我们将要重点讨论两个因素:模型复杂度和训练数据集大小。最后将提出几种解决方案。

欠拟合

我们将模型无法得到较低的训练误差这一现象称作欠拟(underfitting)。

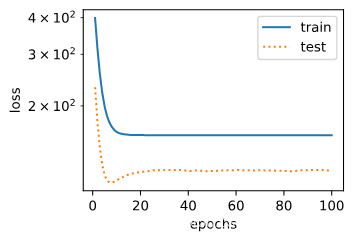

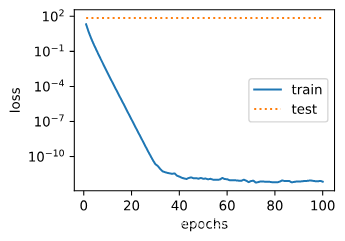

让我们观察一下欠拟合现象:

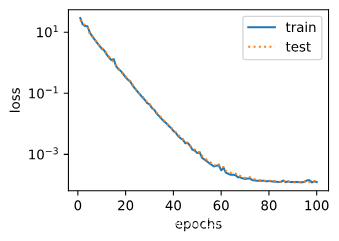

与正常拟合现象相比:

我们可以看到,正常拟合情况下,训练误差和测试误差都很小,且曲线接近重合,模型训练的相当好,有较好的泛化能力,而欠拟合情况下,训练误差和测试误差都很大,更离谱的是测试误差还远比训练误差小,可见此种情况下在训练集上模型都未拟合,训练得出的模型很失败。

针对欠拟合现象,一个解决方案是尝试增加模型的复杂度,模型太简单就会导致欠拟合,举个例子:训练1阶多项式(线性模型)怎样也拟合不了三阶多项式(曲线)拟合的数据吧,势必会发生欠拟合现象,这时改变模型为三阶多项式训练才能较好的拟合数据。

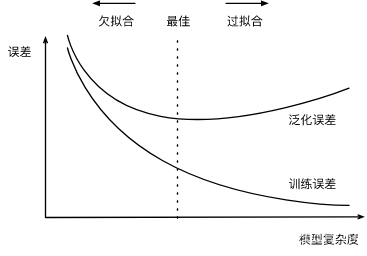

给定数据集,我们来看一下模型复杂度与误差的关系:

通过这个图片我们可以清楚地发现模型复杂度对·过拟合欠拟合现象产生的影响,选择合适复杂度的模型就能一定程度上避免或减弱两种现象的发生。

过拟合

我们将模型的训练误差远小于它在测试数据集上的误差这一现象称为过拟合(overfitting)。

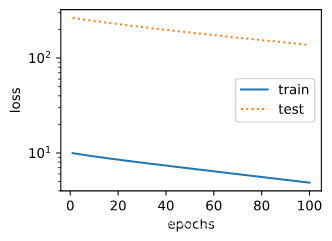

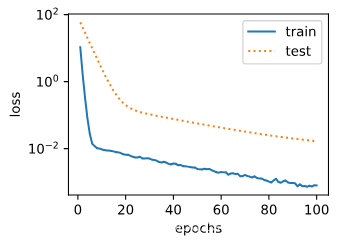

让我们看看过拟合现象:

我们可以看到在这种情况下,虽然训练误差和测试误差都在减小,但是训练误差远小于测试误差,二者甚至不再同一个数量级上,可见训练得到的模型在训练集上拟合的较好,而泛化能力极差。

如何应对过拟合现象的发生呢?

1、增加训练数据数量。一般来说,如果训练数据集中样本数过少,特别是比模型参数数量(按元素计)更少时,过拟合更容易发生。此外,泛化误差不会随训练数据集里样本数量增加而增大。因此,在计算资源允许的范围之内,我们通常希望训练数据集大一些,特别是在模型复杂度较高时,例如层数较多的深度学习模型。我们上面的过拟合现象就是在训练数据过少,甚至远小于模型参数的情况下发生的。

2、减小模型复杂度。我们上面的模型复杂度与误差关系一图已清晰地告诉我们当模型过于复杂时就会对训练数据过度拟合而发生过拟合现象。

3、权重衰减(L2范数正则化)。正则化通过为模型损失函数添加惩罚项使学出的模型参数值较小,是应对过拟合的常用手段。L2L_2L2范数惩罚项指的是模型权重参数每个元素的平方和与一个正的常数的乘积。以线性回归中的线性回归损失函数为例

ℓ(w1,w2,b)=1n∑i=1n12(x1(i)w1+x2(i)w2+b−y(i))2 \ell(w_1, w_2, b) = \frac{1}{n} \sum_{i=1}^n \frac{1}{2}\left(x_1^{(i)} w_1 + x_2^{(i)} w_2 + b - y^{(i)}\right)^2 ℓ(w1,w2,b)=n1i=1∑n21(x1(i)w1+x2(i)w2+b−y(i))2

其中w1,w2w_1, w_2w1,w2是权重参数,bbb是偏差参数,样本iii的输入为x1(i),x2(i)x_1^{(i)}, x_2^{(i)}x1(i),x2(i),标签为y(i)y^{(i)}y(i),样本数为nnn。将权重参数用向量w=[w1,w2]\boldsymbol{w} = [w_1, w_2]w=[w1,w2]表示,带有L2L_2L2范数惩罚项的新损失函数为

ℓ(w1,w2,b)+λ2n∣w∣2, \ell(w_1, w_2, b) + \frac{\lambda}{2n} |\boldsymbol{w}|^2, ℓ(w1,w2,b)+2nλ∣w∣2,

其中超参数λ>0\lambda > 0λ>0。当权重参数均为0时,惩罚项最小。当λ\lambdaλ较大时,惩罚项在损失函数中的比重较大,这通常会使学到的权重参数的元素较接近0。当λ\lambdaλ设为0时,惩罚项完全不起作用。上式中L2L_2L2范数平方∣w∣2|\boldsymbol{w}|^2∣w∣2展开后得到w12+w22w_1^2 + w_2^2w12+w22。

有了L2L_2L2范数惩罚项后,在小批量随机梯度下降中,我们将线性回归一节中权重w1w_1w1和w2w_2w2的迭代方式更改为

w1←(1−ηλ∣B∣)w1−η∣B∣∑i∈Bx1(i)(x1(i)w1+x2(i)w2+b−y(i)),w2←(1−ηλ∣B∣)w2−η∣B∣∑i∈Bx2(i)(x1(i)w1+x2(i)w2+b−y(i)). \begin{aligned} w_1 &\leftarrow \left(1- \frac{\eta\lambda}{|\mathcal{B}|} \right)w_1 - \frac{\eta}{|\mathcal{B}|} \sum_{i \in \mathcal{B}}x_1^{(i)} \left(x_1^{(i)} w_1 + x_2^{(i)} w_2 + b - y^{(i)}\right),\\ w_2 &\leftarrow \left(1- \frac{\eta\lambda}{|\mathcal{B}|} \right)w_2 - \frac{\eta}{|\mathcal{B}|} \sum_{i \in \mathcal{B}}x_2^{(i)} \left(x_1^{(i)} w_1 + x_2^{(i)} w_2 + b - y^{(i)}\right). \end{aligned} w1w2←(1−∣B∣ηλ)w1−∣B∣ηi∈B∑x1(i)(x1(i)w1+x2(i)w2+b−y(i)),←(1−∣B∣ηλ)w2−∣B∣ηi∈B∑x2(i)(x1(i)w1+x2(i)w2+b−y(i)).

可见,L2L_2L2范数正则化令权重w1w_1w1和w2w_2w2先自乘小于1的数,再减去不含惩罚项的梯度。因此,L2L_2L2范数正则化又叫权重衰减。权重衰减通过惩罚绝对值较大的模型参数为需要学习的模型增加了限制,这可能对过拟合有效。

让我们看一下代码:

自定义实现如下:

#定义L2范数惩罚项

def l2_penalty(w):

return (w**2).sum() / 2

loss = torch.nn.MSELoss()

# 添加了L2范数惩罚项

l = loss(net(X, w, b), y) + lambd * l2_penalty(w)

对于Pytorch简洁实现:

建立两个优化器实例分别对w、b更新梯度,不必手动在损失函数后加惩罚项。

optimizer_w = torch.optim.SGD(params=[net.weight], lr=lr, weight_decay=wd) # 对权重参数衰减

optimizer_b = torch.optim.SGD(params=[net.bias], lr=lr) # 不对偏差参数衰减

l = loss(net(X), y).mean()

未添加惩罚项下的训练结果:

惩罚系数lamda为3下的训练结果:

可见过拟合现象得到了抑制。

4、丢弃法。多层感知机中神经网络图描述了一个单隐藏层的多层感知机。其中输入个数为4,隐藏单元个数为5,且隐藏单元hih_ihi(i=1,…,5i=1, \ldots, 5i=1,…,5)的计算表达式为

hi=ϕ(x1w1i+x2w2i+x3w3i+x4w4i+bi) h_i = \phi\left(x_1 w_{1i} + x_2 w_{2i} + x_3 w_{3i} + x_4 w_{4i} + b_i\right) hi=ϕ(x1w1i+x2w2i+x3w3i+x4w4i+bi)

这里ϕ\phiϕ是激活函数,x1,…,x4x_1, \ldots, x_4x1,…,x4是输入,隐藏单元iii的权重参数为w1i,…,w4iw_{1i}, \ldots, w_{4i}w1i,…,w4i,偏差参数为bib_ibi。当对该隐藏层使用丢弃法时,该层的隐藏单元将有一定概率被丢弃掉。设丢弃概率为ppp,那么有ppp的概率hih_ihi会被清零,有1−p1-p1−p的概率hih_ihi会除以1−p1-p1−p做拉伸。丢弃概率是丢弃法的超参数。具体来说,设随机变量ξi\xi_iξi为0和1的概率分别为ppp和1−p1-p1−p。使用丢弃法时我们计算新的隐藏单元hi′h_i'hi′

hi′=ξi1−phi h_i' = \frac{\xi_i}{1-p} h_i hi′=1−pξihi

由于E(ξi)=1−pE(\xi_i) = 1-pE(ξi)=1−p,因此

E(hi′)=E(ξi)1−phi=hi E(h_i') = \frac{E(\xi_i)}{1-p}h_i = h_i E(hi′)=1−pE(ξi)hi=hi

即丢弃法不改变其输入的期望值。让我们对之前多层感知机的神经网络中的隐藏层使用丢弃法,一种可能的结果如图所示,其中h2h_2h2和h5h_5h5被清零。这时输出值的计算不再依赖h2h_2h2和h5h_5h5,在反向传播时,与这两个隐藏单元相关的权重的梯度均为0。由于在训练中隐藏层神经元的丢弃是随机的,即h1,…,h5h_1, \ldots, h_5h1,…,h5都有可能被清零,输出层的计算无法过度依赖h1,…,h5h_1, \ldots, h_5h1,…,h5中的任一个,从而在训练模型时起到正则化的作用,并可以用来应对过拟合。在测试模型时,我们为了拿到更加确定性的结果,一般不使用丢弃法

代码实现:

def dropout(X, drop_prob):

X = X.float()

assert 0 <= drop_prob <= 1

keep_prob = 1 - drop_prob

# 这种情况下把全部元素都丢弃

if keep_prob == 0:

return torch.zeros_like(X)

mask = (torch.rand(X.shape) < keep_prob).float()

return mask * X / keep_prob

X = torch.arange(16).view(2, 8)

dropout(X, 0)

tensor([[ 0., 1., 2., 3., 4., 5., 6., 7.],

[ 8., 9., 10., 11., 12., 13., 14., 15.]])

dropout(X, 0.5)

tensor([[ 0., 0., 4., 6., 8., 0., 0., 14.],

[ 0., 0., 20., 22., 0., 26., 28., 30.]])

可见 大概0.5的被丢弃。

Pytorch简洁实现,把Dropout层添加到激活层和下一个层之间,例:

nn.ReLU(),

nn.Dropout(drop_prob1),

nn.Linear(num_hiddens1, num_hiddens2),

二、梯度消失、梯度爆炸

深度模型有关数值稳定性的典型问题是消失(vanishing)和爆炸(explosion)。

当神经网络的层数较多时,模型的数值稳定性容易变差。

假设一个层数为LLL的多层感知机的第lll层H(l)\boldsymbol{H}^{(l)}H(l)的权重参数为W(l)\boldsymbol{W}^{(l)}W(l),输出层H(L)\boldsymbol{H}^{(L)}H(L)的权重参数为W(L)\boldsymbol{W}^{(L)}W(L)。为了便于讨论,不考虑偏差参数,且设所有隐藏层的激活函数为恒等映射(identity mapping)ϕ(x)=x\phi(x) = xϕ(x)=x。给定输入X\boldsymbol{X}X,多层感知机的第lll层的输出H(l)=XW(1)W(2)…W(l)\boldsymbol{H}^{(l)} = \boldsymbol{X} \boldsymbol{W}^{(1)} \boldsymbol{W}^{(2)} \ldots \boldsymbol{W}^{(l)}H(l)=XW(1)W(2)…W(l)。此时,如果层数lll较大,H(l)\boldsymbol{H}^{(l)}H(l)的计算可能会出现衰减或爆炸。举个例子,假设输入和所有层的权重参数都是标量,如权重参数为0.2和5,多层感知机的第30层输出为输入X\boldsymbol{X}X分别与0.230≈1×10−210.2^{30} \approx 1 \times 10^{-21}0.230≈1×10−21(消失)和530≈9×10205^{30} \approx 9 \times 10^{20}530≈9×1020(爆炸)的乘积。当层数较多时,梯度的计算也容易出现消失或爆炸。

参考:https://www.kesci.com/notebooks/run/5e4a19f580da780037bb4986?label=5e410c983aed37002c3fbbdc&image=5e41555d24e362002dd8fa95&org=5e09de57d2a1cc002ddc2e0e

作者:zpc1219