过拟合、欠拟合及其解决方案等打卡

一、过拟合、欠拟合及其解决方案

1.概念

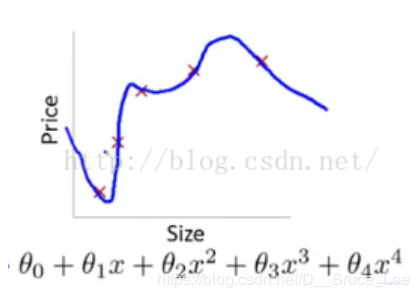

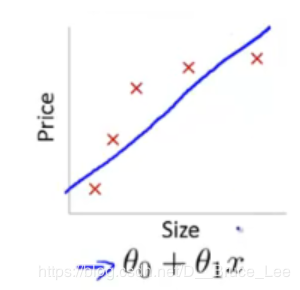

过拟合:模型在训练集上能够得到很好的误差,但是在测试集上的效果很差。

欠拟合:模型无法得到较低的训练误差。(在训练集和测试集上都不能得到较好的误差)

2.多项式函数拟合实验

1)torch.cat((A,B),dim)

它是将两个张量(tensor)拼接在一起,cat是concatnate的意思,即拼接,联系在一起。

使用torch.cat((A,B),dim)时,除拼接维数dim数值可不同外其余维数数值需相同,方能对齐。

2)nn.Linear(in_features,out_features,bias=True)

nn.Linear()是用于设置网络中的全连接层的,需要注意的是全连接层的输入与输出都是二维张量,一般形状为[batch_size, size],不同于卷积层要求输入输出是四维张量。参数如下:

in_features指的是输入的二维张量的大小,即输入的[batch_size, size]中的size。

out_features指的是输出的二维张量的大小,即输出的二维张量的形状为[batch_size,output_size],当然,它也代表了该全连接层的神经元个数。

bias为偏差,布尔型。True为使用偏差。

3.权重衰减:L2 范数正则化

在模型原损失函数基础上添加L2范数惩罚项,从而得到训练所需要最小化的函数,可以解决模型过拟合。

二、梯度消失、梯度爆炸

1.概念

当神经网络的层数较多时,模型的数值稳定性容易变差。

假设一个层数为 LL的多层感知机的第 ll层 H(l)的权重参数为 W(l),输出层 H(L)的权重参数为 W(L)。为了便于讨论,不考虑偏差参数,且设所有隐藏层的激活函数为恒等映射(identity mapping) ϕ(x)=x 。给定输入 X ,多层感知机的第 l层的输出 H(l)=XW(1)W(2)…W(l) 。此时,如果层数 l 较大, H(l)的计算可能会出现衰减或爆炸。举个例子,假设输入和所有层的权重参数都是标量,如权重参数为0.2和5,多层感知机的第30层输出为输入 X 分别与 0.230≈1×10−21(消失)和 530≈9×1020 (爆炸)的乘积。当层数较多时,梯度的计算也容易出现消失或爆炸。

2.环境因素

1)协变量偏移

这里我们假设,虽然输入的分布可能随时间而改变,但是标记函数,即条件分布P(y∣x)不会改变。(理解:训练集中特征对应的标签始终不变,但是测试集中的特征改变了。)

2)标签偏移

当我们认为导致偏移的是标签P(y)上的边缘分布的变化,但类条件分布是不变的P(x∣y)时,就会出现相反的问题。当我们认为y导致x时,标签偏移是一个合理的假设。例如,通常我们希望根据其表现来预测诊断结果。在这种情况下,我们认为诊断引起的表现,即疾病引起的症状。有时标签偏移和协变量移位假设可以同时成立。例如,当真正的标签函数是确定的和不变的,那么协变量偏移将始终保持,包括如果标签偏移也保持。有趣的是,当我们期望标签偏移和协变量偏移保持时,使用来自标签偏移假设的方法通常是有利的。这是因为这些方法倾向于操作看起来像标签的对象,这(在深度学习中)与处理看起来像输入的对象(在深度学习中)相比相对容易一些。(理解:训练集中特征始终不变,但是测试集中的标签有多种。)

3)概念偏移

不同地区对同一术语的概念不同。

三、卷积神经网络进阶

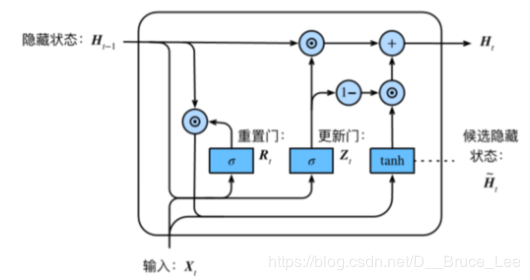

1.RNN存在梯度较容易出现衰减或爆炸的情况,因此提出门控神经网络。

⻔控循环神经⽹络:捕捉时间序列中时间步距离较⼤的依赖关系

Rt=σ(XtWxr+Ht−1Whr+br)(重置门:有助于捕捉时间序列⾥短期的依赖关系)

Zt=σ(XtWxz+Ht−1Whz+bz)(更新⻔:有助于捕捉时间序列⾥⻓期的依赖关系)

H˜t=tanh(XtWxh+(Rt⊙Ht−1)Whh+bh)

Ht=Zt⊙Ht−1+(1−Zt)⊙H˜t

2.初始化参数

nn.Parameter()

可以把这个函数理解为类型转换函数,将一个不可训练的类型Tensor转换成可以训练的类型parameter并将这个parameter绑定到这个module里面

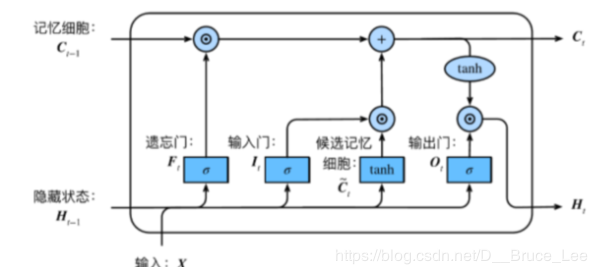

3.LSTM(长短期记忆long short-term memory )

It=σ(XtWxi+Ht−1Whi+bi)

Ft=σ(XtWxf+Ht−1Whf+bf)(遗忘门:控制上一时间步的记忆细胞 输入门:控制当前时间步的输入)

Ot=σ(XtWxo+Ht−1Who+bo)(输出门:控制从记忆细胞到隐藏状态)

C˜t=tanh(XtWxc+Ht−1Whc+bc)

Ct=Ft⊙Ct−1+It⊙C˜t(记忆细胞:⼀种特殊的隐藏状态的信息的流动)

Ht=Ot⊙tanh(Ct)

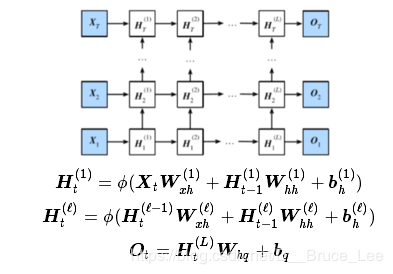

4.深度循环神经网络

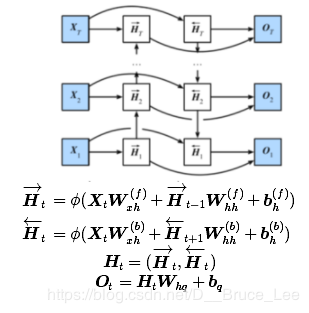

5.双向循环神经网络

作者:D__Bruce_Lee