Decoupled Attention Network for Text Recognition——论文解读

摘要:

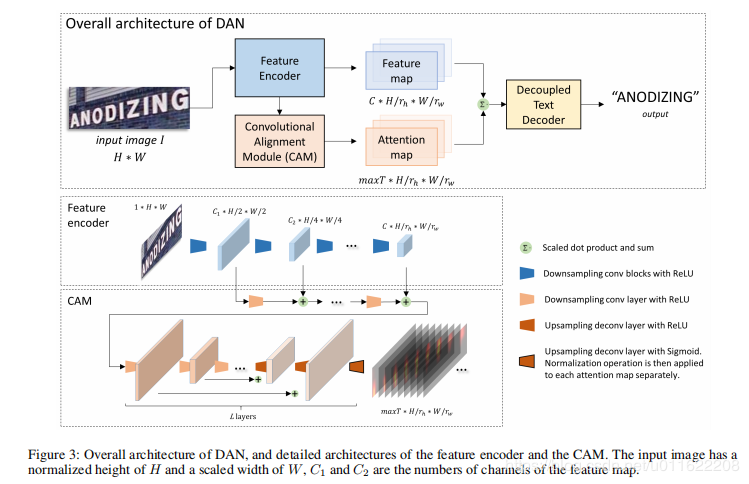

文字识别方法在不规则文本识别上,多采用attention的方式,但是采用自回归模型的attention容易存在attention对齐的问题。文章提出了一个 a decoupled attention network (DAN)网络。其主要由:1.特征采集器;2.一个卷积对齐模块,根据编码器的输出进行特征对齐;3.一种解耦的文本解码器,通过联合使用特征图和注意图进行最终预测

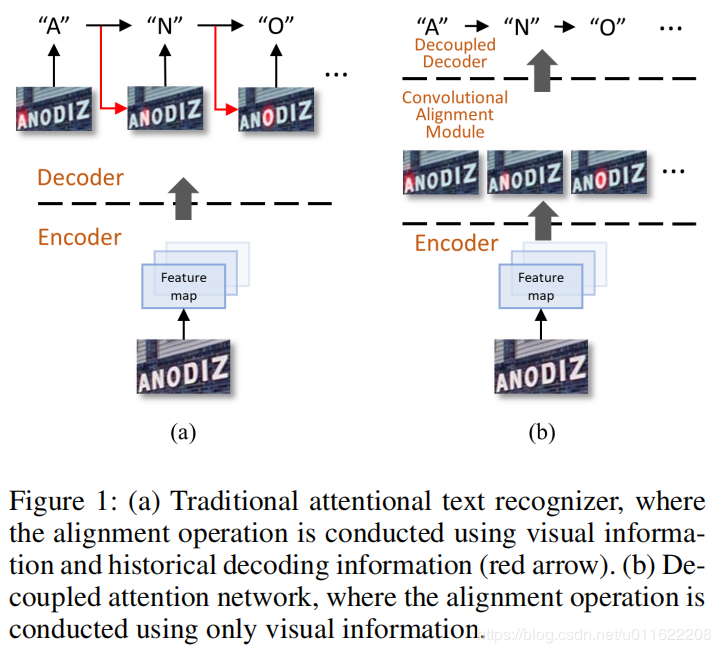

attention在文字识别中一般是用于特征对齐和文字识别(最后的分类部分),传统的attention一般利用两部分的信息。1. encoder输出的视觉编码特征,2. 历史解码信息/或者先前解码结果的嵌入向量。注意力机制背后的主要思想是匹配。给定特征映射中的一个特征,其注意评分是通过评分它与历史解码信息的匹配程度来计算的

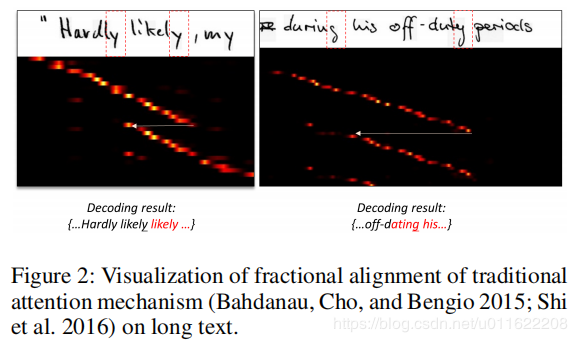

传统的注意机制经常遇到严重的对准问题,同时由于解码过程中的耦合关系不可避免地导致误差积累和传播。

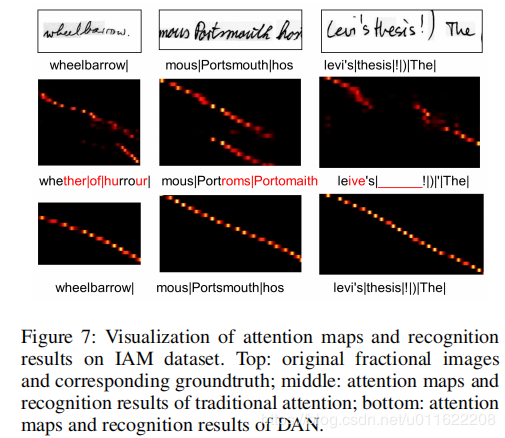

解码结果容易影响基于匹配的比对。在左侧图像中,两个**连续的“ly”**混淆了匹配操作;在右边的图像中,错误识别的结果“混淆了匹配操作”。还观察到注意机制很难排列长序列。因此,找到一种将比对操作与历史解码信息解耦的方法是很直观的减少负面影响。

DAN不需要解码阶段的反馈从而避免了解码误差的积累和传播(相当于不需要前面解码结果的嵌入向量作为输入)

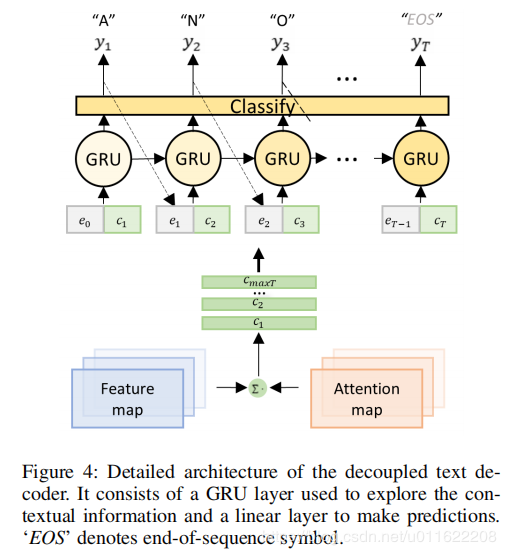

DAN由三部分组成:1.CNN;2.CAM;3.a decoupled text decoder。CAM 采用多尺度的特征作为输入,在通道层面输出 attention map用全卷积网络。decoupled text decoder采用cnn的输出和attention map作为输入,采用GRU进行解码。

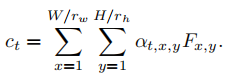

et是前一个解码结果的嵌入向量,ct是attention map和特征的输出,然后送入GRU进行不定长解码

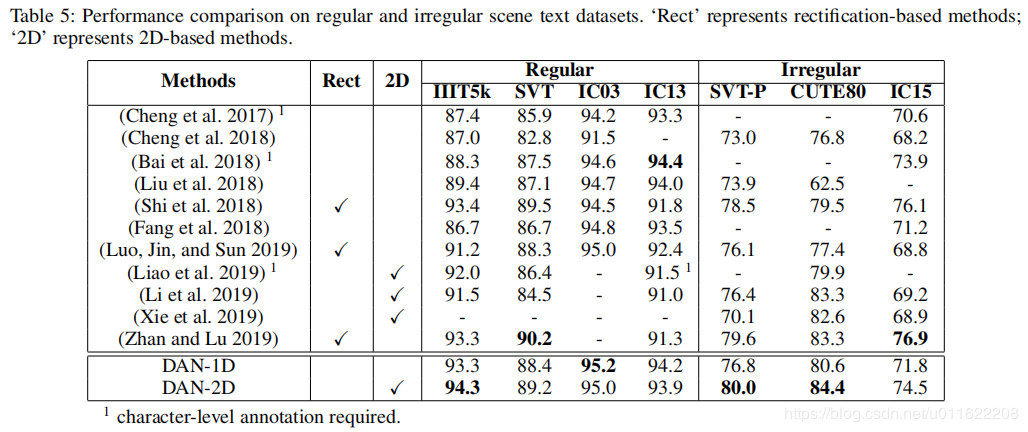

结果

结果

作者:怡宝2号